音频分类 - Jupyter Notebooks

通过audio_classification_UrbanSound8K.ipynb示例脚本,可以演示如何将 ClearML 集成到 Jupyter Notebook 中,该 Notebook 使用 PyTorch、TensorBoard 和 TorchVision 在 UrbanSound8K 数据集上训练神经网络进行音频分类。该示例在训练和测试中调用 TensorBoard 方法来报告标量、音频调试样本和频谱图可视化。频谱图可视化通过调用 Matplotlib 方法绘制。该示例还演示了如何将参数连接到任务并进行记录。脚本运行时,会在Audio Example项目中创建一个名为audio classification UrbanSound8K的任务。

标量

准确率、学习率和训练损失标量会自动记录,以及资源利用率图(标题为:monitor: machine),并显示在SCALARS中。

调试样本

音频样本和频谱图会自动记录并显示在DEBUG SAMPLES中。

音频样本

双击缩略图即可播放音频样本。

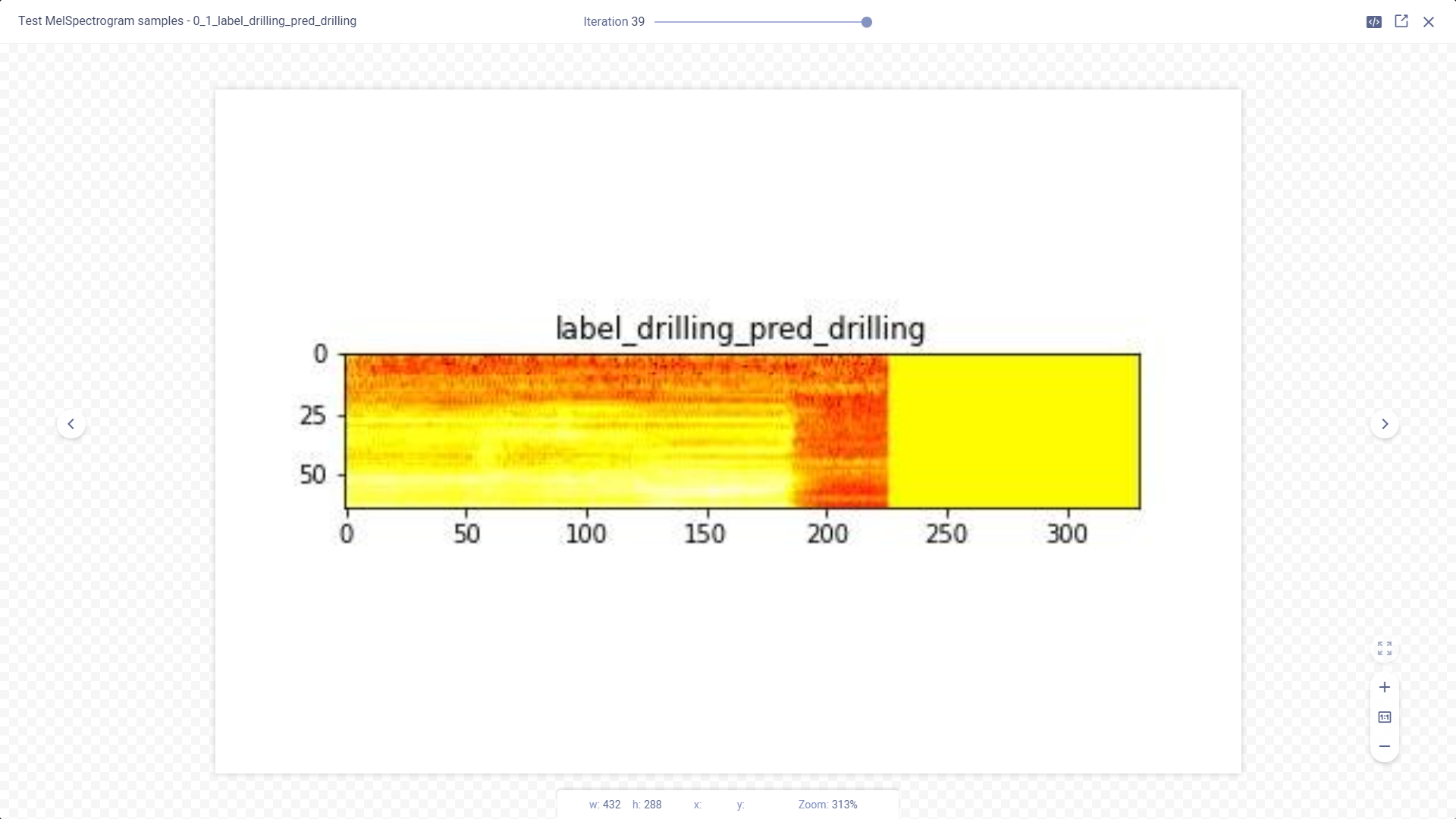

频谱图可视化

双击缩略图可以在图像查看器中查看频谱图。

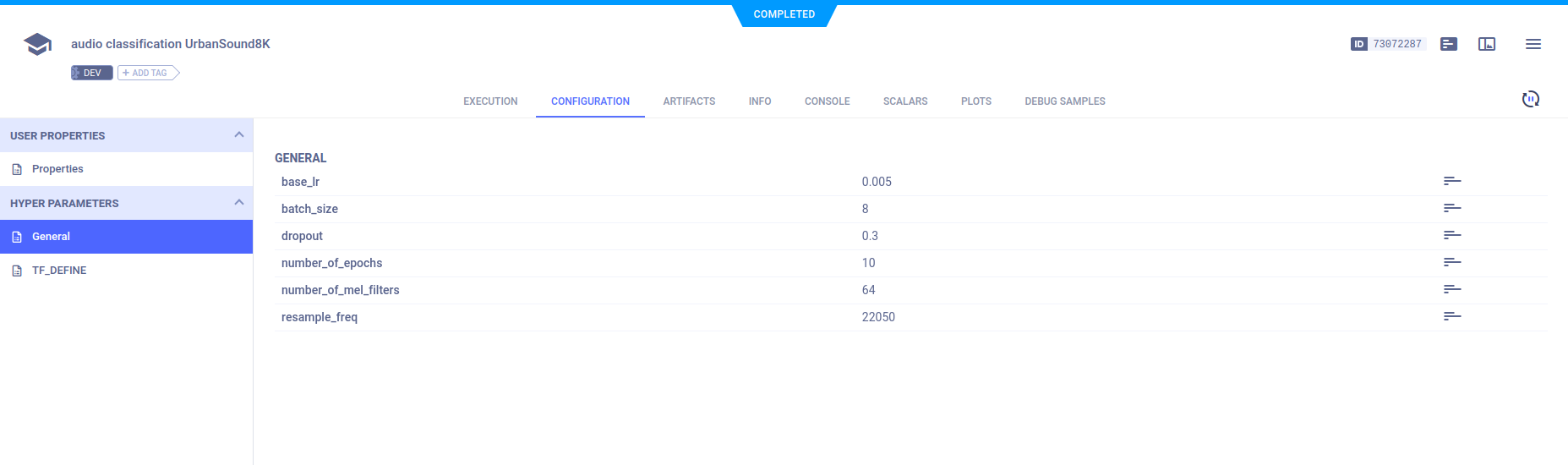

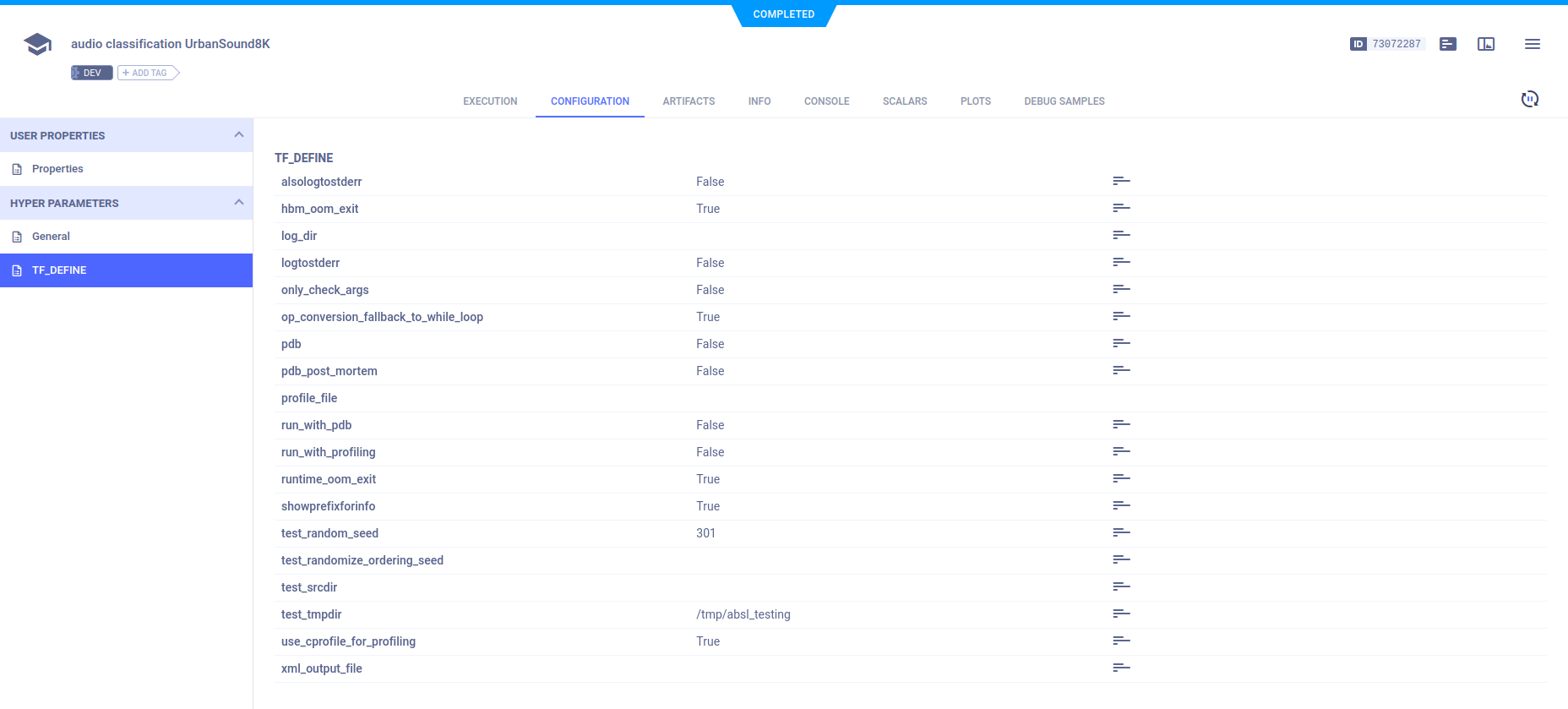

超参数

ClearML 会自动记录 TensorFlow 定义。通过调用Task.connect方法将参数字典连接到任务并进行记录。

configuration_dict = {

'number_of_epochs': 10,

'batch_size': 4,

'dropout': 0.25,

'base_lr': 0.001

}

configuration_dict = task.connect(configuration_dict) # enabling configuration override by clearml

参数字典显示在CONFIGURATION > HYPERPARAMETERS > General中。

TensorFlow 定义显示在 TF_DEFINE 子部分中。

控制台

训练进度的控制台输出,以及所有其他控制台输出,都显示在CONSOLE中。