Llama.cpp 模型部署

企业版功能

llama.cpp 模型部署应用在 ClearML Enterprise 计划下提供。

llama.cpp 模型部署应用允许用户使用 llama.cpp 快速部署 GGUF 格式的 LLM 模型。llama.cpp 模型部署应用将在您选择的机器上提供模型服务。一旦应用实例正在运行,它会通过一个安全的、可公开访问的网络端点来提供您的模型服务。该应用会监控端点活动,如果模型在指定的非活动最大时长内保持非活动状态,则会关闭。

AI 应用网关

llama.cpp 模型部署应用使用了应用网关路由器 (App Gateway Router),它为模型实现了安全、经过身份验证的网络端点。

如果 ClearML AI 应用网关不可用,模型端点可能无法访问。更多信息,请参阅 AI 应用网关。

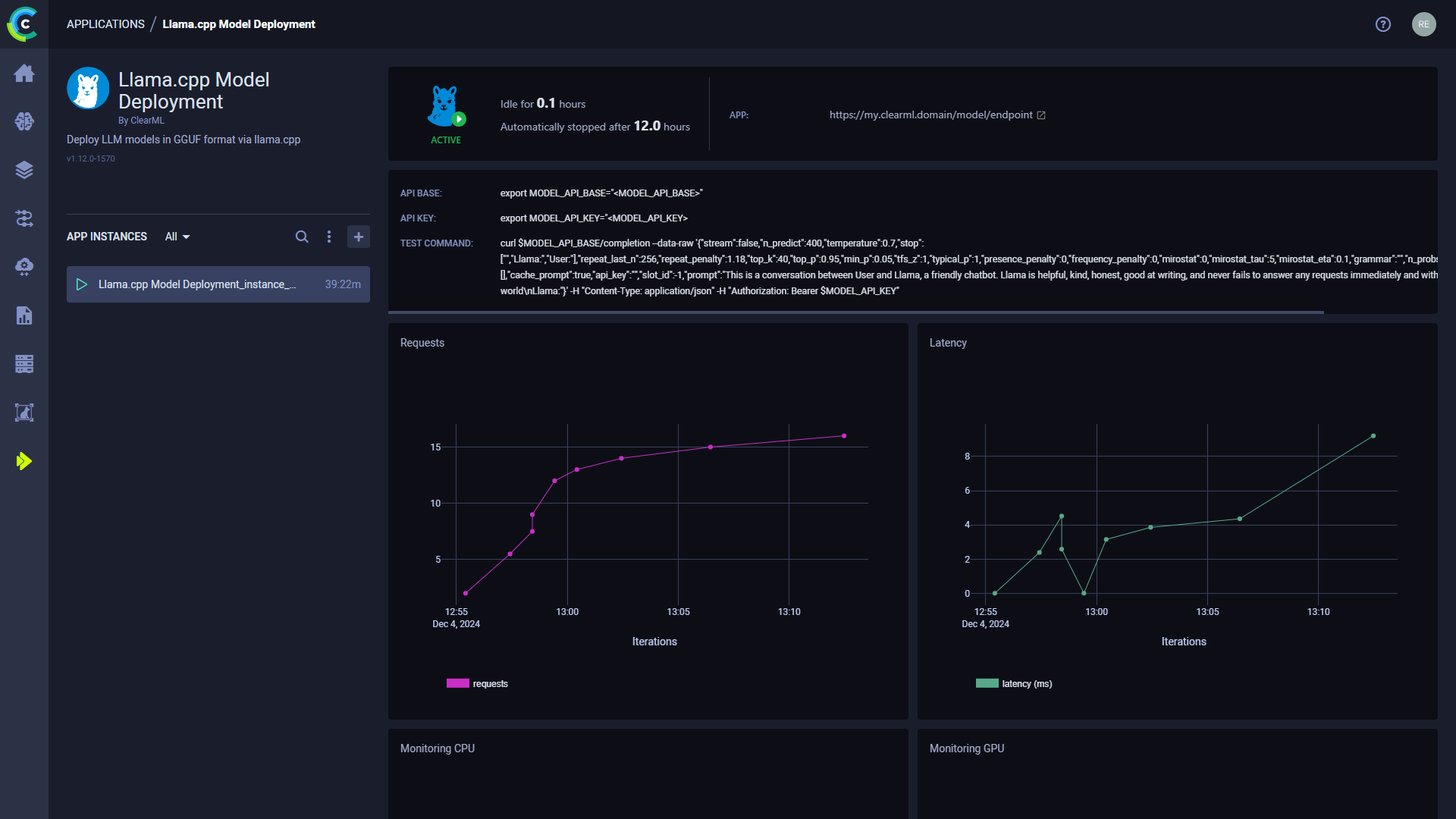

启动 llama.cpp 模型部署实例后,您可以在其仪表盘中查看以下信息:

- 状态指示器

- 应用实例正在运行且处于活跃使用中

- 应用实例正在设置中

- 应用实例处于空闲状态

- 应用实例已停止

- 空闲时长 - 自上次活动以来经过的时间

- 应用 - 模型端点的公开可访问 URL。活跃的模型端点也显示在 模型端点 表中,您可以查看和比较端点详情并随时间监控状态。

- API 基础 - 模型端点的基础 URL

- API 密钥 - 模型端点的身份验证密钥

- 测试命令 - 测试已部署模型的命令行示例

- 请求数 - 随时间变化的请求数量

- 延迟 - 随时间变化的请求响应时间 (毫秒)

- 随时间变化的端点资源监控指标

- CPU 使用率

- 网络吞吐量

- 磁盘性能

- 内存性能

- GPU 利用率

- GPU 显存使用量

- GPU 温度

- 控制台日志 - 控制台日志显示应用实例的控制台输出:设置进度、状态更改、错误消息等。

嵌入 ClearML 可视化

您可以将应用实例仪表盘中的图表嵌入到 ClearML 报告 中。这些可视化图表会随应用实例的更新而实时更新。企业版计划支持在外部工具(例如 Notion)中嵌入资源。将鼠标悬停在图表上,点击 复制嵌入代码,然后导航到报告中粘贴嵌入代码。

llama.cpp 模型部署实例配置

配置新的 llama.cpp 模型部署实例时,您可以填写所需的参数或重用之前启动的实例的配置。

使用之前启动的实例配置启动应用实例,可通过以下选项之一:

- 克隆之前启动的应用实例将打开实例启动表单,其中已预填充原始实例的配置。

- 导入应用配置文件。您可以在查看之前启动的实例配置时,将其配置导出为 JSON 文件。

预填充的配置表单可以在启动新的应用实例之前进行编辑。

要配置新的应用实例,请点击 Launch New 以打开应用配置表单。

配置选项

- 导入配置 - 导入应用实例配置文件。这将用文件中的值填充配置表单,您可以在启动应用实例之前修改这些值。

- 项目名称 - 用于存储您的 llama.cpp 模型部署应用实例的 ClearML 项目

- 任务名称 - 您的 llama.cpp 模型部署应用实例的 ClearML 任务 名称

- 队列 - llama.cpp 模型部署应用实例任务将被入队的 ClearML 队列(确保已将 Agent 分配给该队列)

- 模型 - ClearML 模型 ID 或 Hugging Face 模型。模型必须是 GGUF 格式。如果您使用的是 HuggingFace 模型,请务必传递 GGUF 文件的路径。例如:

provider/repo/path/to/model.gguf - 通用

- Hugging Face Token - 用于访问需要身份验证的 Hugging Face 模型的 Token

- GPU 层数 - 存储在 VRAM 中的层数。

9999表示应将所有层加载到 VRAM 中。用于将模型卸载到 CPU RAM 上。

- 高级选项

- 空闲时间限制 (小时) - 应用实例将关闭的最大空闲时间

- 最后活动报告间隔 (秒) - 报告应用最后活动的频率。用于在机器指标较低但应用实际仍在运行时阻止应用进入空闲状态。