更快构建更智能的 AI 工作流程

ClearML 的 AI 开发中心为您的 AI/ML 工作流程提供了基础构建模块。它简化了数据准备、编目和流程设计,实现了无缝协作和可扩展性。凭借诸如用于自动化数据跟踪和版本控制的数据运营 (DataOps)、用于动态管理非结构化数据的超级数据集 (Hyper-Datasets) 以及用于跟踪和重现 ML 实验每一步的实验管理器 (Experiment Manager) 等功能,ClearML 确保您的工作流程高效且可追溯。从集中的模型库 (Modelstore) 管理到连接和自动化任务的逻辑驱动型管道 (Pipelines),ClearML 使您的团队能够简化运营、专注于创新,并更快、更智能地构建 AI 解决方案。功能包括

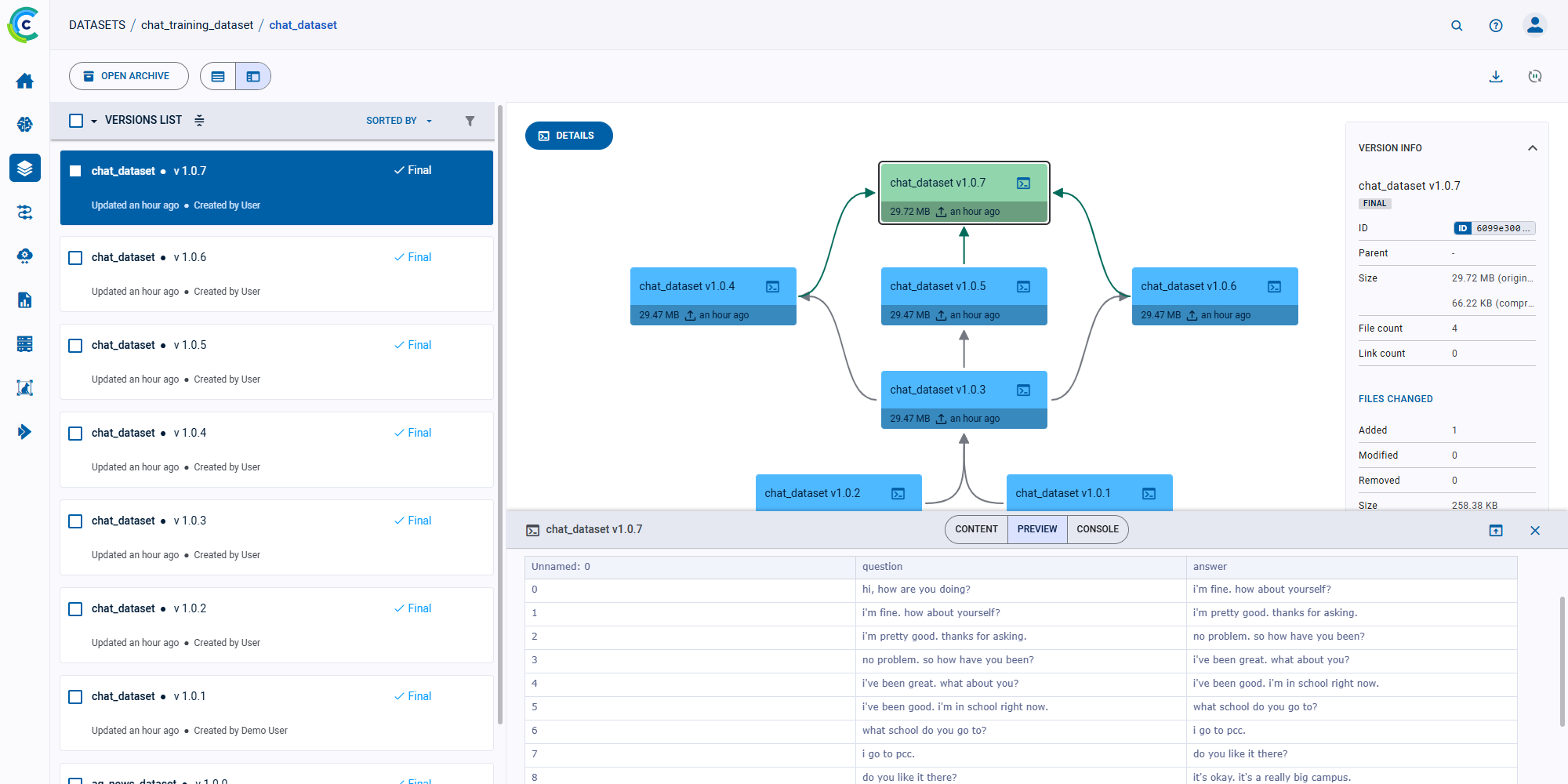

数据运营 (DataOps)

简化数据准备、跟踪和版本控制

ClearML 数据运营通过使您的数据集可追溯、可访问且安全来简化数据管理。从可视化到集成,它实现了无缝协作和以数据为中心的 AI 工作流程。

- 从完全联邦式数据管理中获益:自动跟踪、记录和版本化您的数据集,以实现完全可追溯性。使用 ClearML 直观的 Web 界面,您可以从任何地方可视化、采样、切片和共享您的数据,同时利用元数据驱动的抽象来保护原始数据源,确保数据主权。

- 确保安全性和可访问性:项目级基于角色的访问控制 (RBAC)、SSO 和 LDAP 集成等企业级安全功能可确保数据安全,同时仅对授权用户开放。

- 赋能跨职能团队:通过让所有数据工程师、科学家和产品经理都能探索其完整的数据目录,他们可以轻松协作,利用工具处理数据集、识别偏差并简化开发,而无需额外的工程开销。

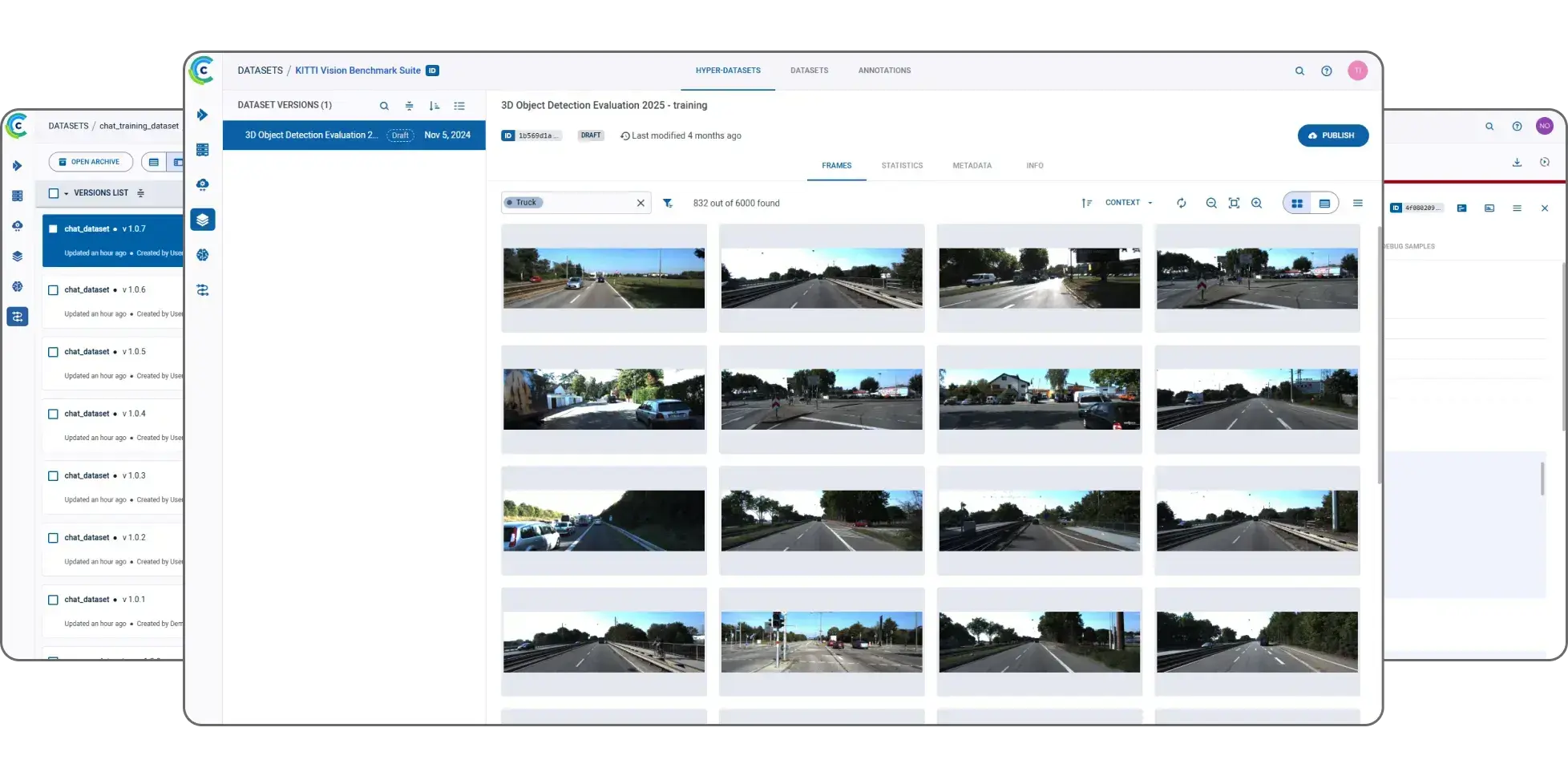

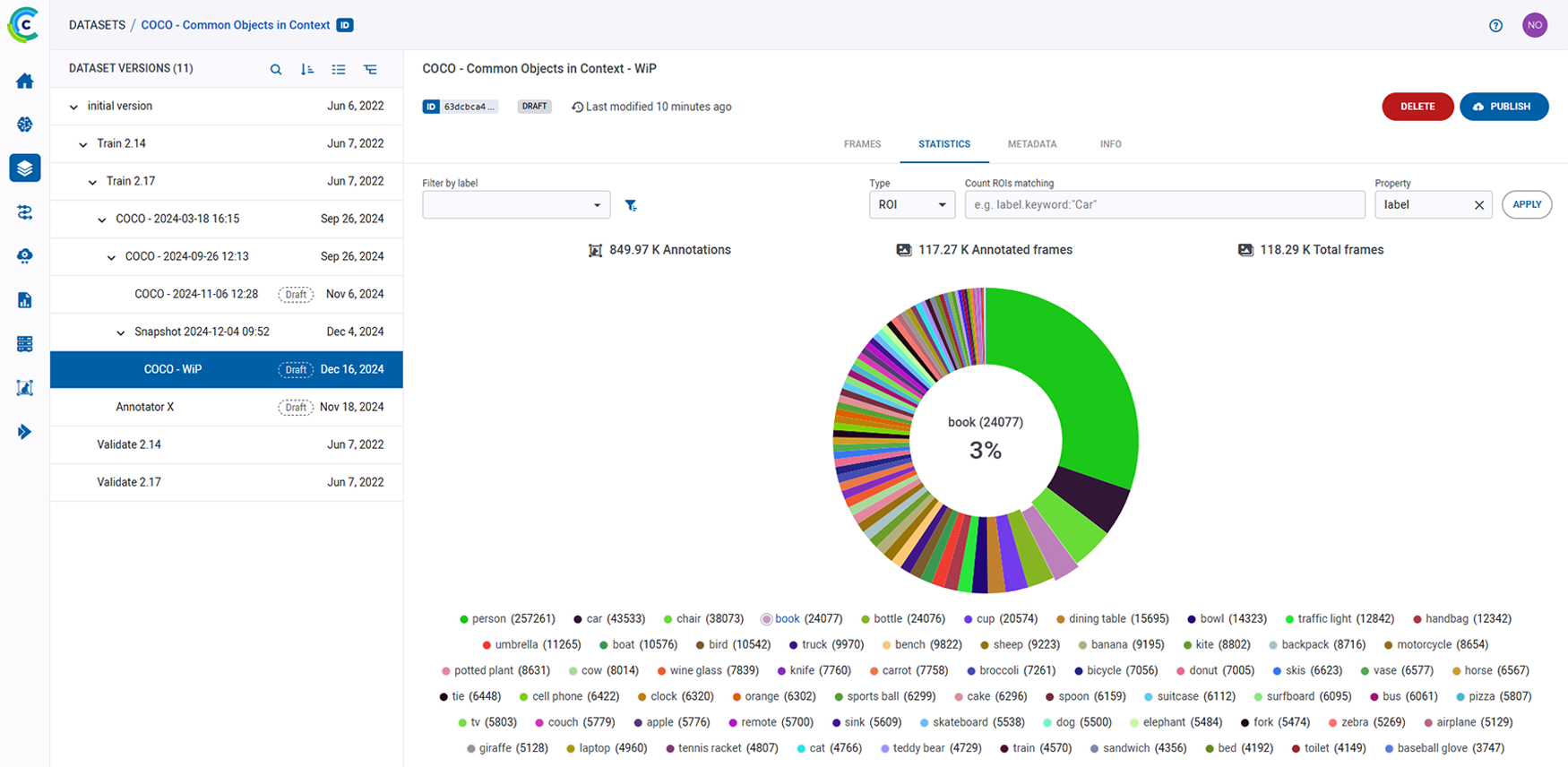

超级数据集 (Hyper-Datasets)

优化非结构化数据管理以加速模型开发

ClearML 超级数据集彻底改变了非结构化数据管理方式,从而实现快速模型开发和优化。凭借元数据驱动的控制和无缝编排,它使团队能够在不增加复杂性的情况下最大限度地提高性能。根据向量运行相似性搜索,并实时过滤和排序,全面探索您的数据。

- 实时元数据控制:使用抽象元数据实时查询、过采样、去除偏差和切片数据集,确保您的数据流经过精细调整,以实现最佳模型性能。

- 自动化数据集处理:将超级数据集与编排相结合,可自动启动数据集配置作为实验的一部分——无需更改代码。

- 简化数据视图:创建带有元数据或注解的远程数据集抽象本地视图,可用于实验并通过基于角色的访问控制 (RBAC) 进行保护。

实验管理器 (Experiment Manager)

管理所有 ML 实验的单一事实来源

ClearML 实验管理器是您轻松精准管理机器学习实验的终极解决方案。作为单一事实来源,它确保了可重现性、可扩展性,并与您喜爱的工具和基础设施无缝集成。

- 轻松实验跟踪:只需两行代码即可自动记录代码、配置、数据集和输出。使用 ClearML 直观的界面即时比较模型并确保可重现性。

- 可扩展且安全的架构:凭借可扩展的开源架构,处理数千个并发实验。SSO、LDAP 集成和 RBAC 等企业级安全功能可确保安全协作。

- 集成生态系统:连接流行的框架、可视化工具、IDE 和版本控制系统。实时可视化指标、调试实验,并简化数据科学家、ML 工程师和 DevOps 团队的工作流程。

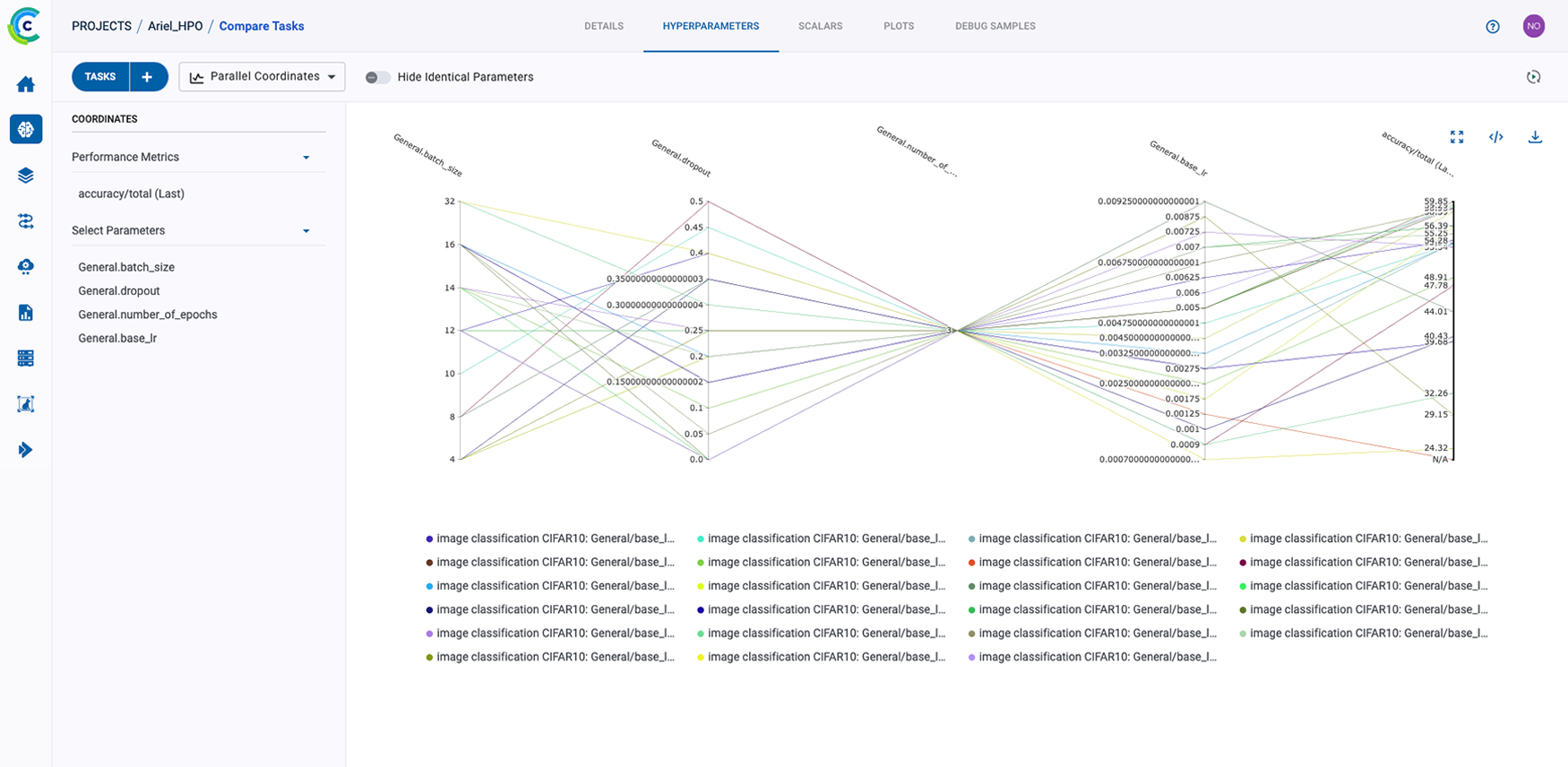

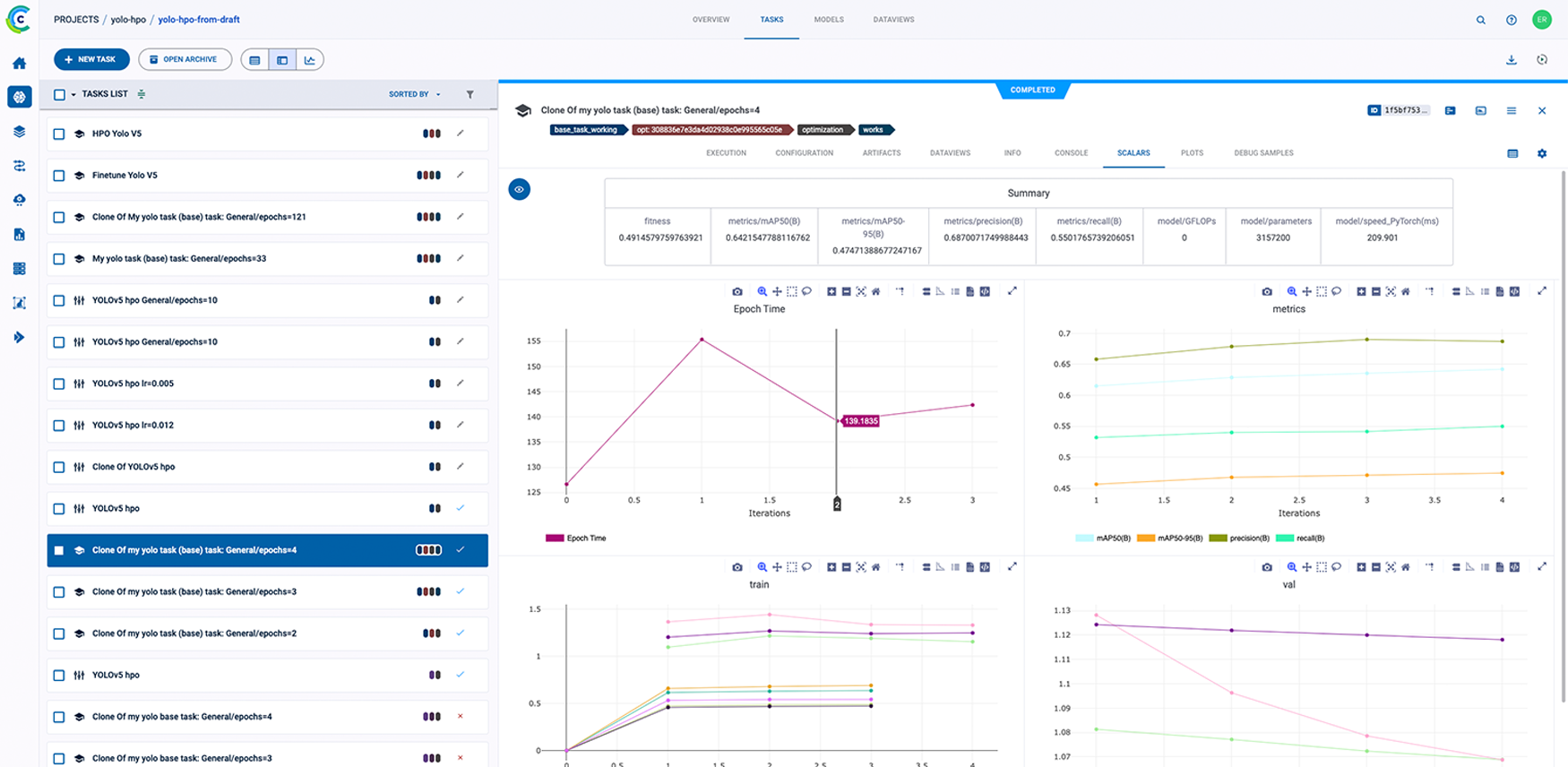

超参数优化 (Hyperparameter Optimization)

无需更改代码即可减少训练时间并提高模型准确性

ClearML 内置的超参数优化功能简化了超参数调整过程,无需修改原始代码。它克隆基础实验,自动启动和跟踪具有不同参数集的原始实验的多个副本,并实时跟踪指标,确保高效且可扩展的优化。

- 自动化实验克隆与优化:ClearML 提供了一个精简的 UI,用于设置超参数优化任务,并系统地调整参数以优化既定目标,例如最小化验证损失或最大化准确性。

- 灵活的目标设置和搜索策略:支持可定制的目标指标(例如,验证、损失)、搜索策略(例如,网格搜索、随机搜索)和优化算法(例如,Optuna、BOHB),以针对单个或多个目标量身定制优化。

- 高效资源管理:提供并发任务、执行队列和时间限制等控制功能,以有效管理计算资源。存储优化配置和归档表现不佳任务等附加选项有助于保持工作流程井然有序。

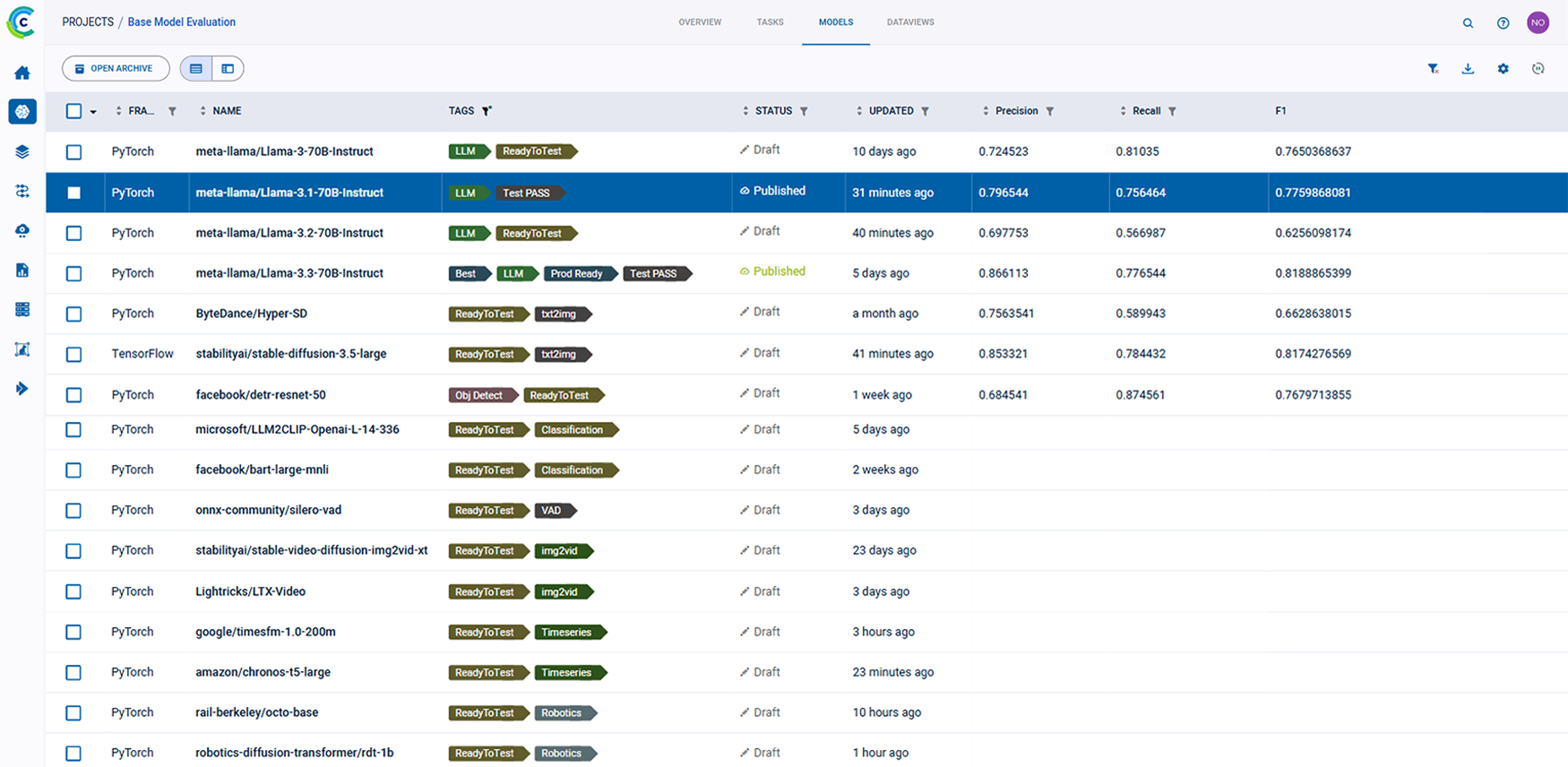

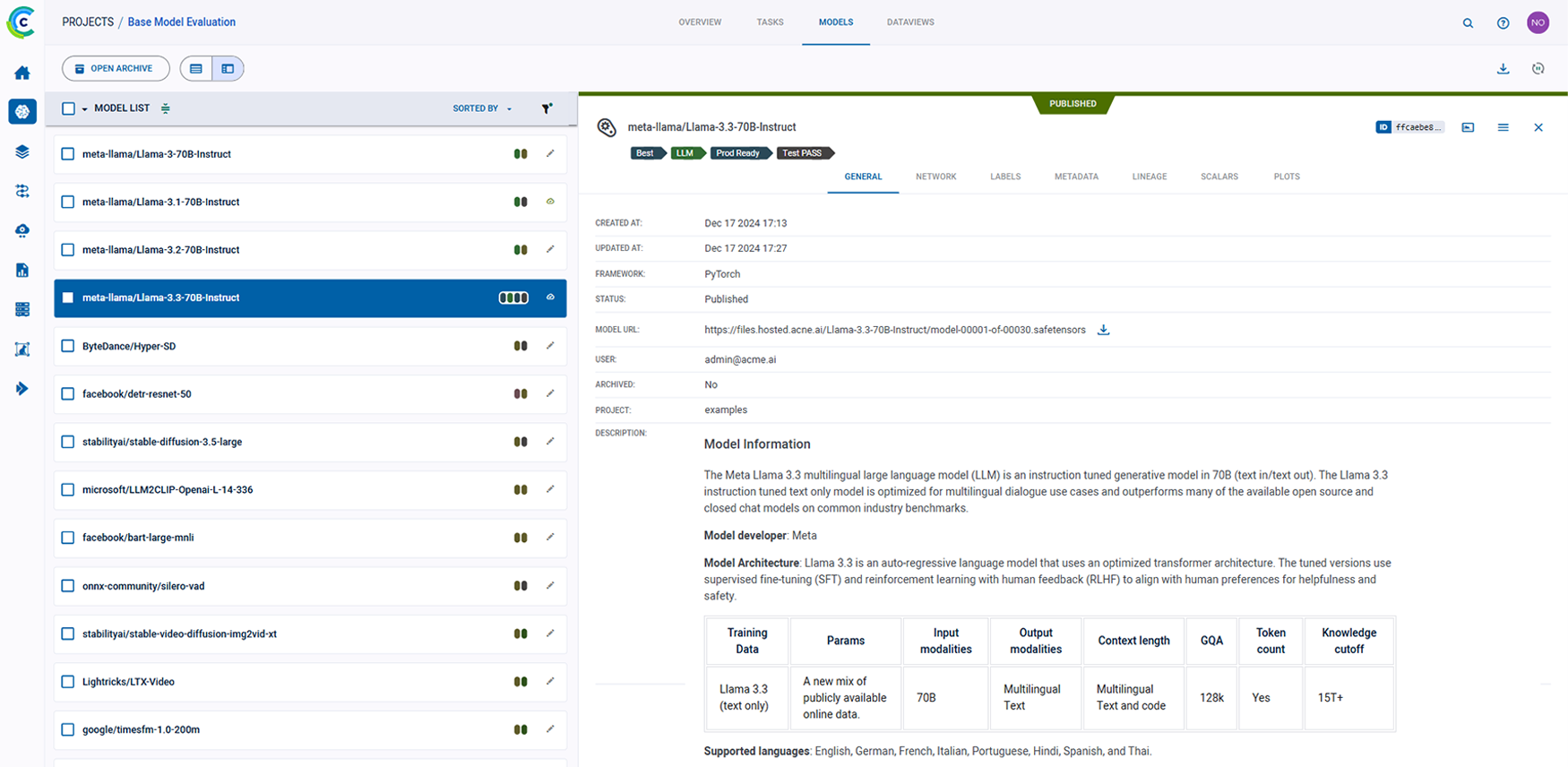

模型库 (Modelstore)

存储、版本化和管理用于部署的训练模型

ClearML 模型库集中并简化了模型管理,使在整个组织内编目、跟踪和共享模型变得容易。凭借全面的可追溯性和集成能力,它确保了从训练到生产的高效工作流程。

- 全面的模型跟踪和可追溯性:通过跟踪、更新和谱系追踪,维护模型生命周期的全面可观测性。借助 ClearML 直观的模型目录,实现大规模可重现性和治理。

- CI/CD 工作流程自动化:通过用于注册、标记或发布模型的 CI/CD 触发器,无缝集成到您的管道中。ClearML 简化了模型从训练到生产的过渡,同时保持了工作流程的透明度。

- 团队协作与集成:使数据科学家和 ML 工程师能够轻松访问共享模型和实验结果。ClearML 与 TensorFlow、PyTorch 和 scikit-learn 等主要框架集成,提供统一的模型管理体验。

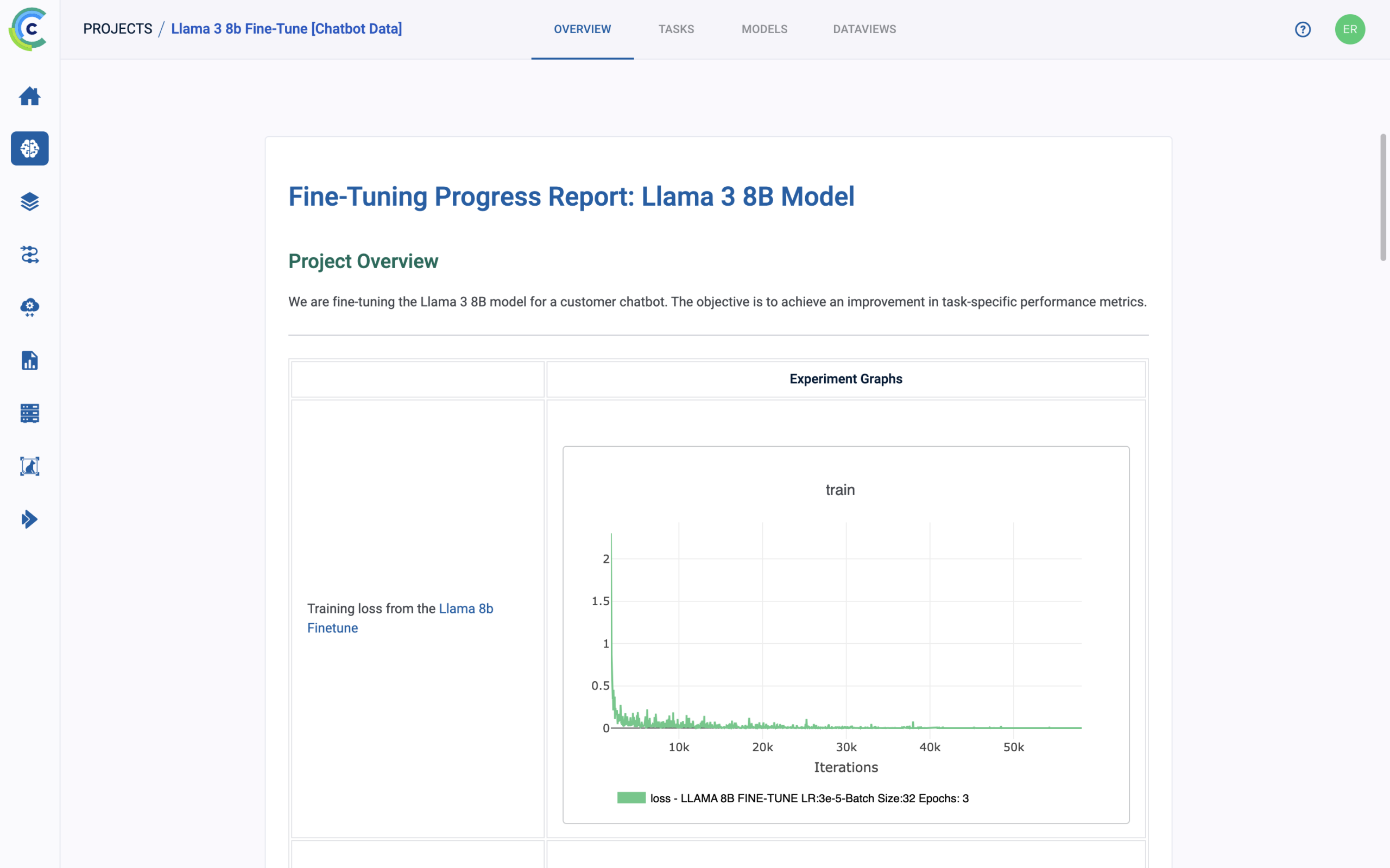

报告 (Reports)

分享和可视化来自实验和数据集的洞见

ClearML 报告使您可以轻松与团队或利益相关者分享洞见、进度和结果。通过实时协作和灵活集成,您可以创建交互式的、数据丰富的报告,让每个人都保持一致和了解情况。

- 交互式仪表板和报告:在实时仪表板中总结表现最佳的模型、任务和指标。将实时图表、图示和绘图直接嵌入到 ClearML 报告或 Notion、Jupyter Notebooks 和 Confluence 等第三方工具中。

- 协作式知识共享:与队友协作编写基于 Markdown 的报告,创建内容丰富、可导出的文档,用于在整个组织内分享进度和评估模型性能。

- 灵活的集成:将 ClearML 仪表板和可视化内容嵌入 Grafana、Monday.com 或 Google Colab 等热门第三方工具,确保无缝知识共享并增强团队沟通。

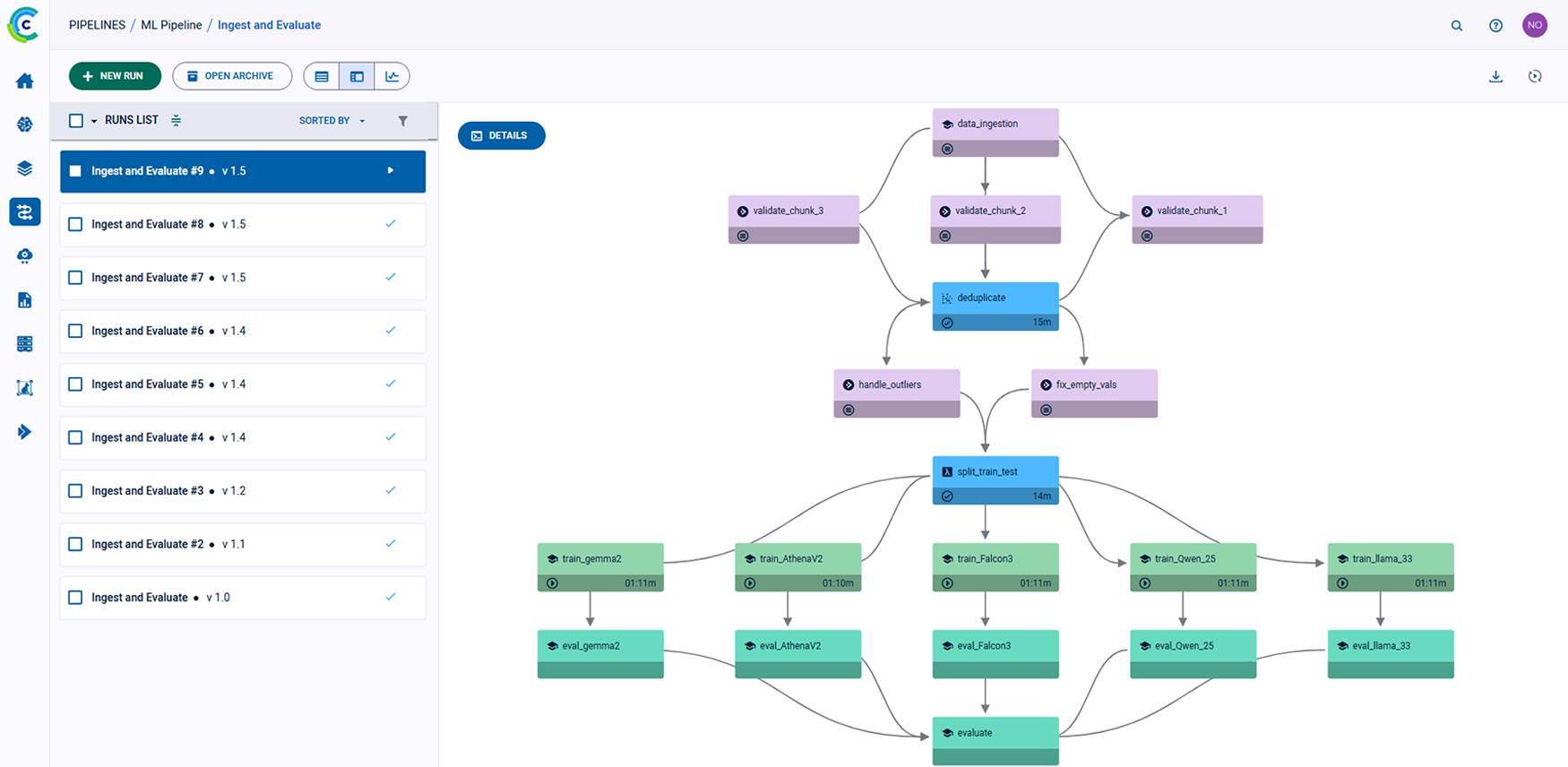

管道 (Pipelines)

使用可跟踪、缓存且可重用的逻辑驱动型 ML 管道扩展工作负载

ClearML 管道通过实现可跨多台机器和集群运行的可扩展、逻辑驱动型管道,简化并优化了机器学习工作流程。凭借无缝调试、缓存和 CI/CD 集成,ClearML 帮助 ML 工程师节省时间并专注于创新。

- 逻辑驱动且可扩展的管道:将管道编写为代码,完全支持 if、循环和业务逻辑。跨多台机器或集群执行任务,利用 Python 包、git 和容器以实现最大灵活性。

- 优化执行和调试:自动缓存管道组件以减少执行时间,并在本地机器上进行调试,简化故障排除。

- 无缝 CI/CD 集成:通过 GitHub Actions、Jenkins 和 Airflow 等热门第三方 CI/CD 工具触发和监控管道,确保自动化流程顺畅。

更智能地训练,更快地扩展:优化您的 AI 训练工作流程

ClearML 简化并增强了模型训练过程,实现了更快的协作、高效的资源管理和无缝的可扩展性。凭借详细的日志记录、智能作业优先级设置和动态自动扩展等功能,您可以运行完全可重现的训练过程,同时最大限度地发挥基础设施的潜力。无论您是在本地、云端还是混合环境中管理任务,ClearML 的解决方案都能确保公平的资源分配、优化的作业调度和安全的编排,满足您的所有训练需求。功能包括

训练 (Train)

加速协作和反馈周期,更快做好生产准备

ClearML 训练通过实现无缝协作、可重现性和可扩展性,简化了模型训练过程。凭借自动日志记录、智能资源管理和企业级安全等功能,它帮助您的团队更快地交付生产就绪模型。

- 可重现且自动化的工作流程:自动记录配置、数据集和检查点,确保完全可重现性。使团队成员能够轻松启动共享实验、修改参数和查看结果。

- 跨环境可扩展训练:在本地、云端或混合基础设施(包括 Kubernetes、HPC 集群 (Slurm/PBS) 和裸金属环境)上扩展模型训练,同时通过优先级作业队列优化资源使用。

- 企业级安全与协作:通过 SSO、LDAP 集成和 RBAC 等功能实现安全协作,使团队能够更快地工作并高效利用资源,同时不损害数据安全。

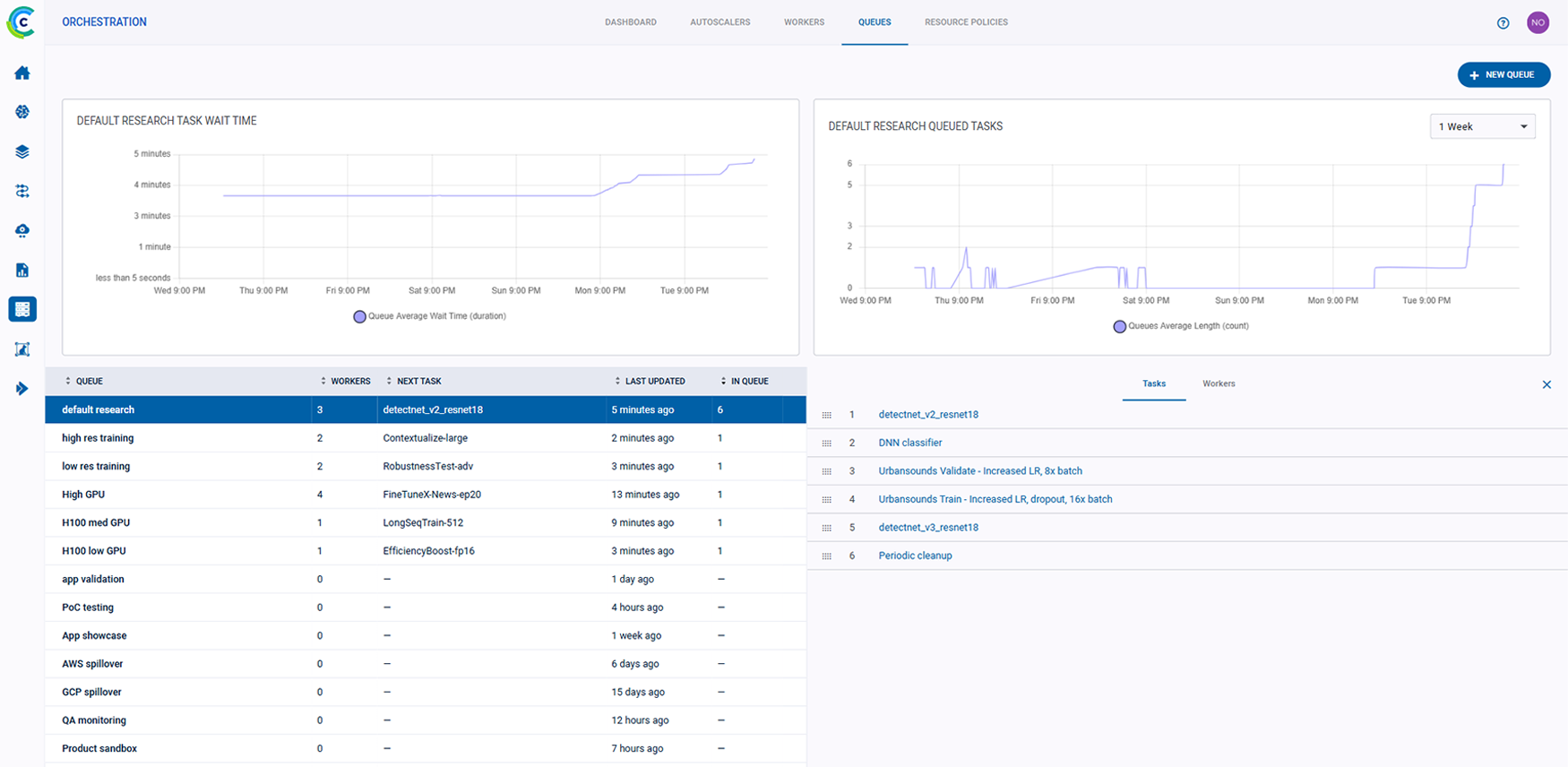

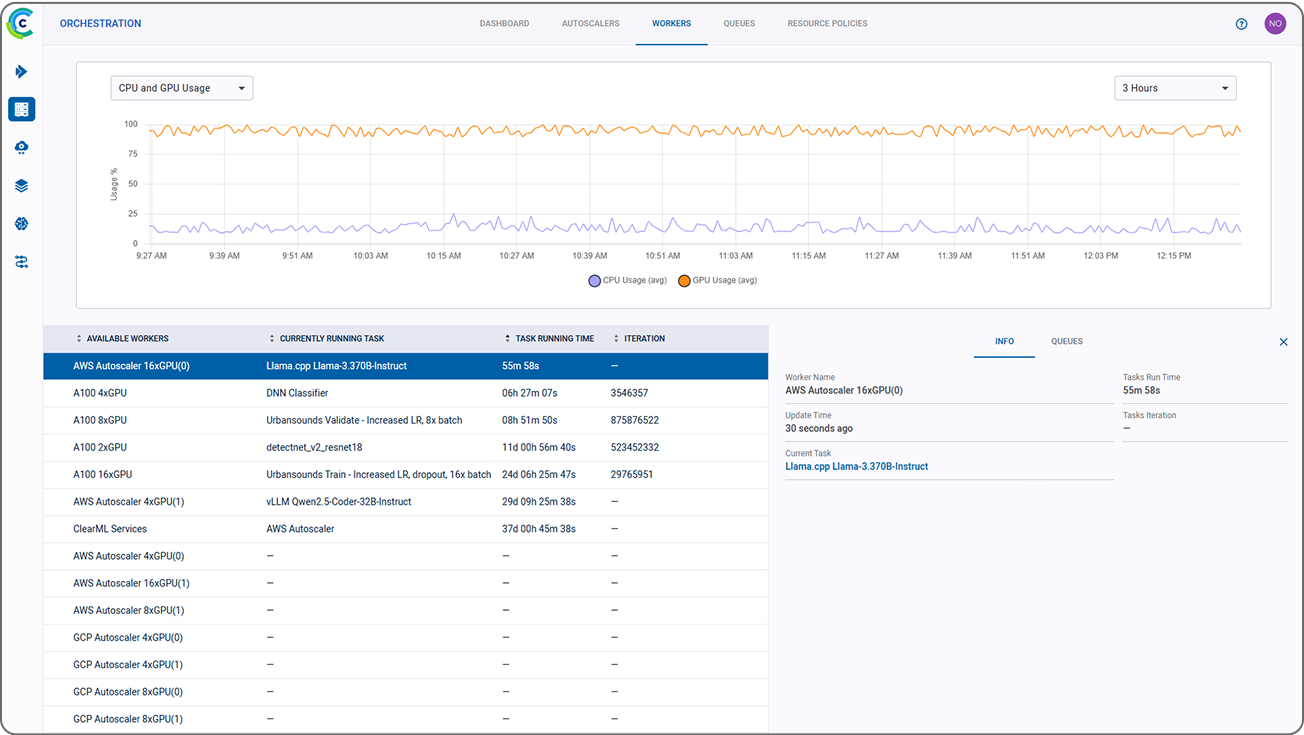

调度 (Schedule)

为作业确定优先级和优化资源分配

ClearML 调度提供了强大的计算资源管理工具,使您能够为工作负载确定优先级并进行优化。凭借作业优先级设置、资源监控和高效负载均衡等功能,它确保了资源的最大利用率和精简的工作流程。

- 优先级作业队列:构建和管理优先级作业队列,以实现高效的资源分配。企业用户可以利用 GPU 时间切片和团队级预算控制等高级功能,最大化 GPU 利用率。

- 资源监控和负载均衡:通过直观的仪表板监控按用户组、优先级或预算划分的 GPU 和 CPU 使用情况。轻松地在机器之间重新分配作业或添加资源以应对工作负载需求。

- 超配额资源利用:利用超配额能力充分利用空闲容量,确保即使在高峰需求期间也没有资源闲置。

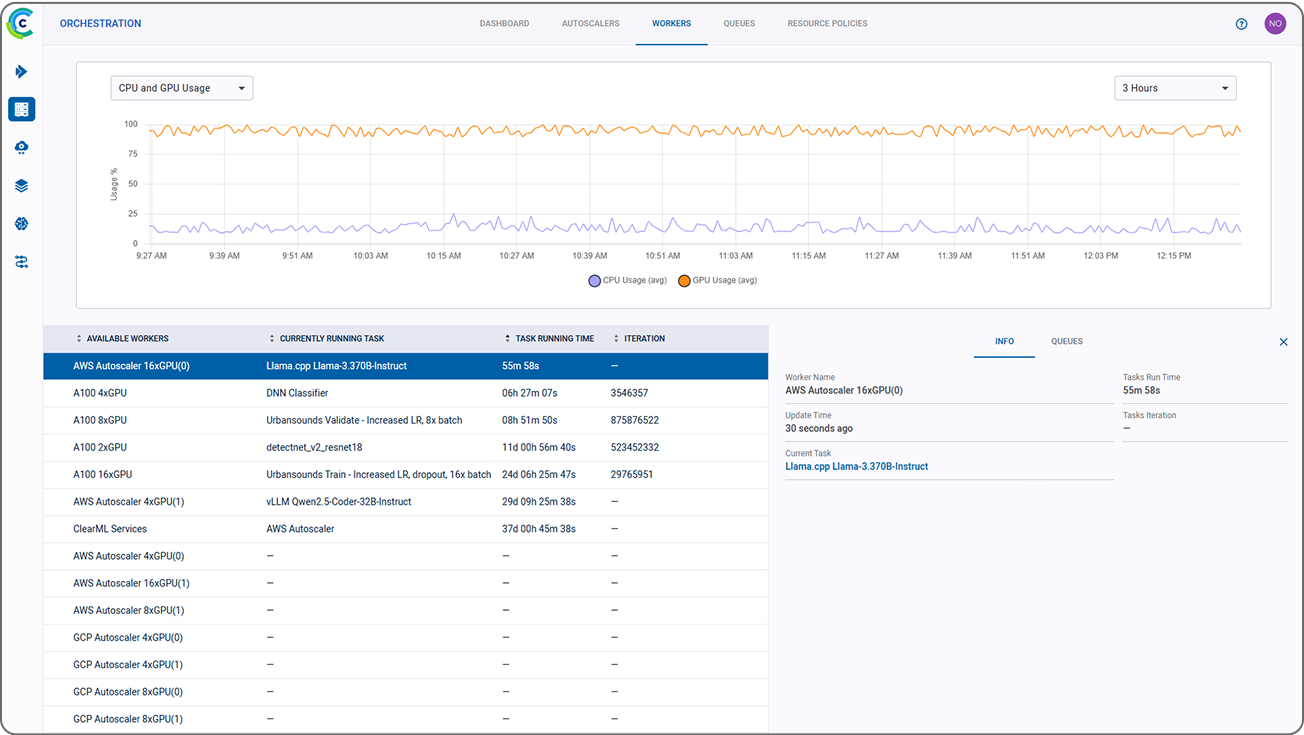

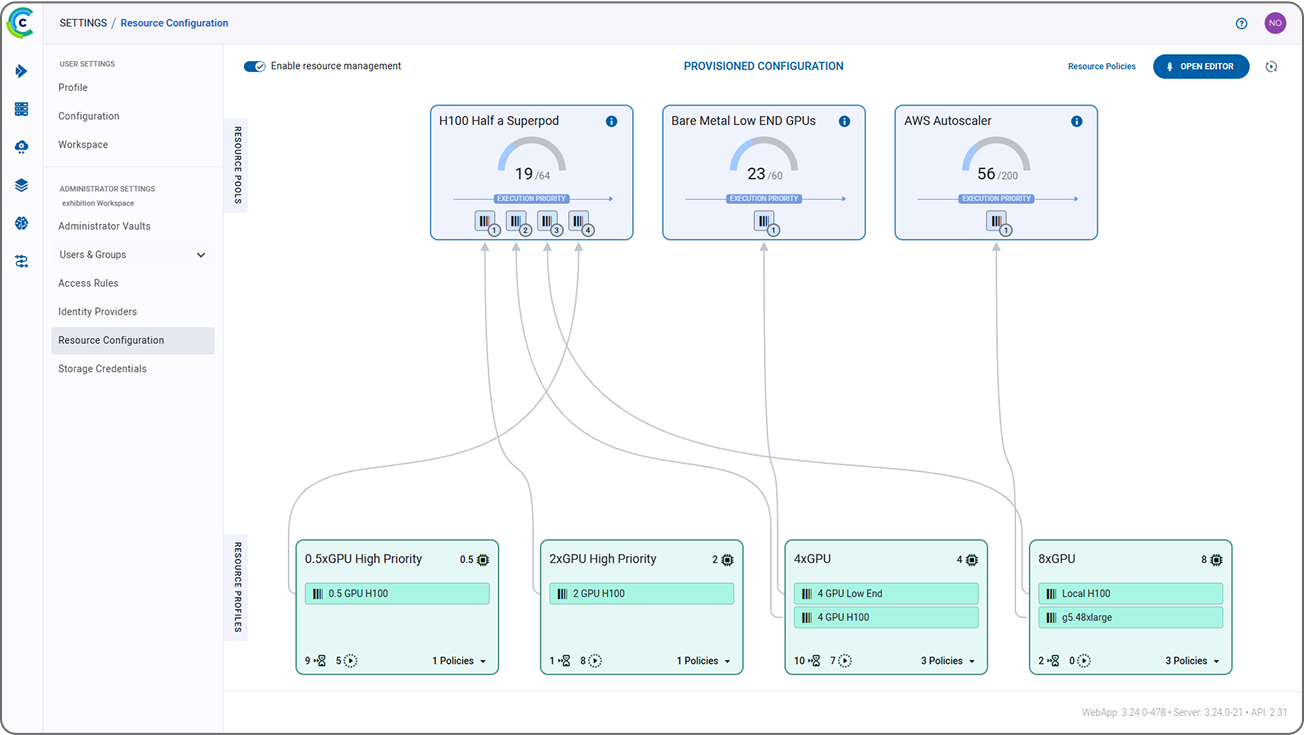

编排 (Orchestrate)

通过打包环境并将其发送到远程机器来简化部署

ClearML 编排通过在多样化基础设施上实现无缝打包和执行,简化了 AI 工作负载的管理和部署。凭借动态资源池、灵活的基础设施支持和企业级安全等功能,它使您的团队能够高效且安全地扩展。

- 跨基础设施无缝部署:从任何地方(代码、CLI、Git 或 Web)将任务启动到任何基础设施(包括云、本地、Kubernetes、Slurm 或 Docker)中,无需手动容器化。

- 动态资源管理:在本地和云设置之间动态汇集和扩展计算资源,并具有溢出能力以应对高峰需求。使利益相关者能够自助访问,以优化工作流程效率。

- 企业级安全和灵活性:通过 SSO 和 LDAP 集成确保安全、经过身份验证的通信。访问强大的控制平面,用于管理跨 Kubernetes、Slurm、裸金属或混合基础设施的工作负载。

云溢出 (Cloud Spillover)

优先利用本地资源,最大程度地减少不必要的云支出

ClearML 的云溢出功能使工作负载仅在本地机器完全利用时才在云计算上处理。通过优先使用本地计算资源,组织能够控制云成本,同时确保在高峰期提供计算能力。

- 逻辑驱动的负载均衡:使用 RBAC 配置资源策略,以确定何时应使用云资源,例如在本地计算资源已完全利用的高峰期。

- 无缝云实例:利用 ClearML 无摩擦的调度和编排功能,自动启动云实例以支持额外的工作负载,而不会对任务或最终用户产生任何影响。

- 云预算管理:最大程度地减少云消耗以控制成本。创建云计算访问规则和策略,并为每个项目或团队设置云预算,以密切管理利用率。

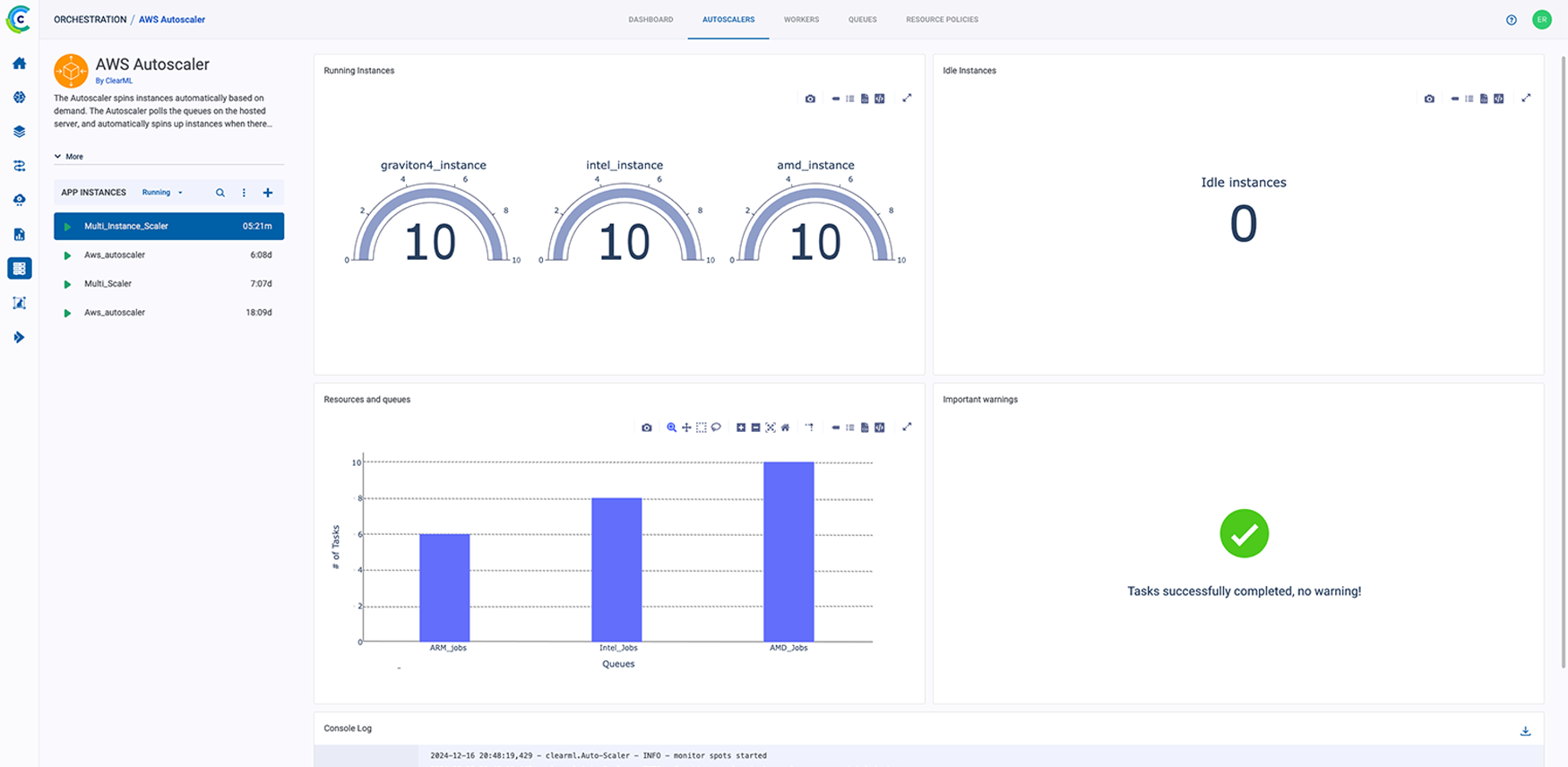

自动扩展器 (Autoscalers)

根据工作负载需求动态扩展计算资源

ClearML 的自动扩展器通过在需要时动态启动额外的云容量来简化计算资源的扩展。凭借无缝集成和高效资源管理,它支持结合本地和云基础设施的混合模型,以实现最大灵活性和成本效益。

- 轻松云扩展:以最小的开销将 AWS、GCP 或 Azure 的计算资源添加到您现有的设置中。自动扩展器支持裸金属、Kubernetes 和混合基础设施,实现无缝扩展。

- 自动化资源管理:通过自动启动和关闭机器来优化云资源使用,确保预算不浪费在空闲容量上。

- 混合云灵活性:动态组合云和本地资源(Kubernetes、Slurm、裸金属),构建企业级混合计算模型,提供可扩展性,避免供应商锁定。

自信地部署 AI 模型

ClearML 简化了从模型开发到生产的过渡,为操作型 AI 工作流程实现了高效的服务和扩展。凭借实时和批量处理的灵活选项、统一的模型仓库以及全面的工作流程可见性,ClearML 确保了在 Kubernetes、云端或混合设置上的无缝部署。通过动态基础设施管理、自动化凭证处理和混合计算能力优化资源利用,为您的团队提供了高效且大规模服务模型的工具。功能包括

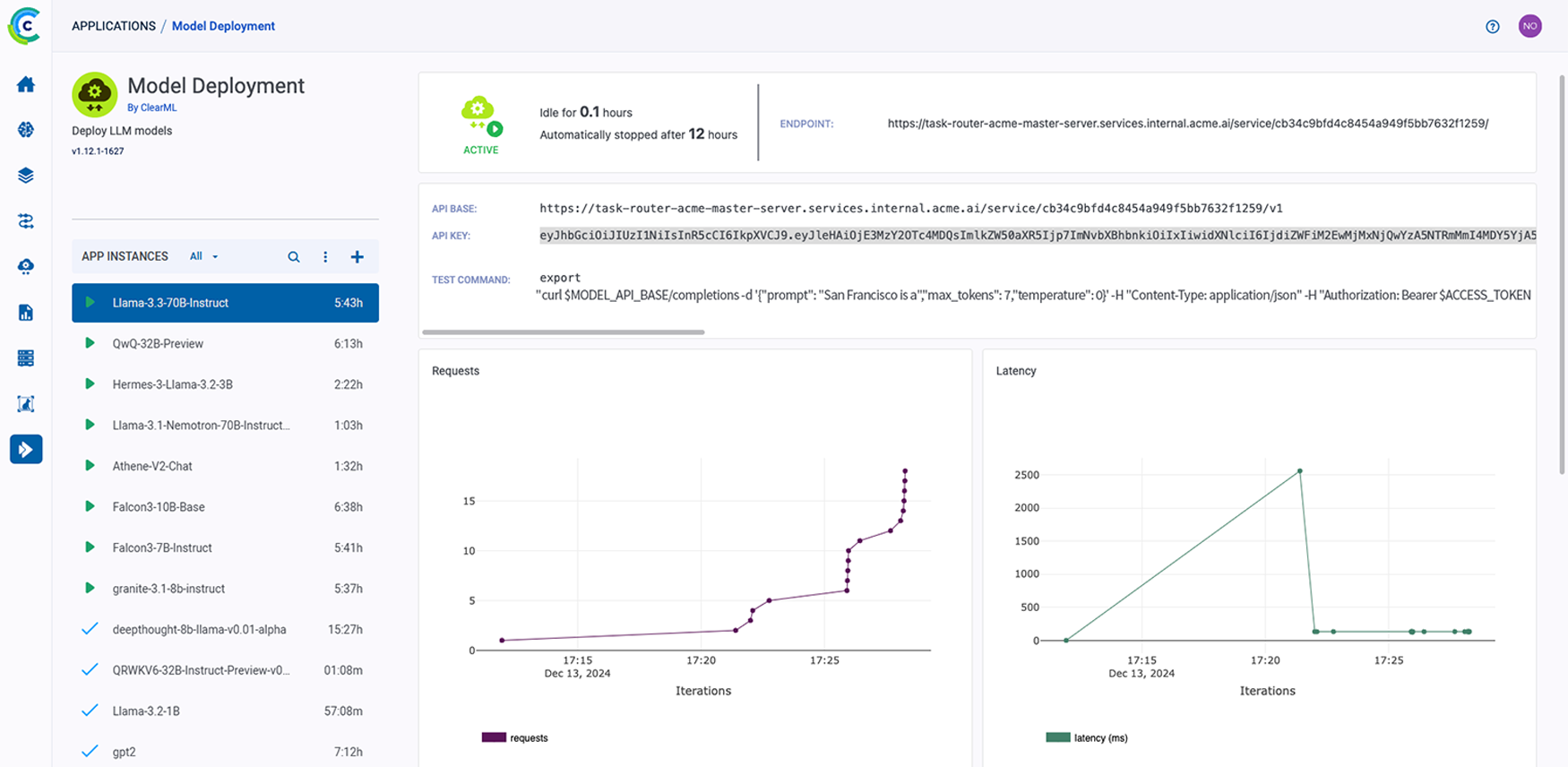

部署 (Deploy)

简化模型服务和推理管道

ClearML 部署通过两种灵活的模型服务选项,简化了从模型开发到生产的旅程:计划批量处理和通过 RestAPI 进行实时推理。这些选项提供了无缝的可扩展性、强大的安全性和与现有工作流程的轻松集成,使团队能够高效地交付操作型 AI。

- 两种模型服务选项

- 批量模式:在云端或本地环境中计划具有自动扩展支持、自定义指标监控和真正的 CI/CD 工作流程的模型推理作业。

- 通过 RestAPI 进行实时推理:利用带有自定义预处理代码的优化 GPU/CPU 服务,可扩展到跨 Kubernetes 或容器化解决方案处理数百万个请求。

- 轻松灵活的部署:直接从 UI、CLI 或通过编程方式部署模型。与现有仪表板集成,创建自定义指标,并利用内置的漂移检测和异常警报进行监控。

- 可扩展性和资源优化:横向扩展到多节点设置或大规模实时请求。解耦 GPU 和 CPU 处理,最大化资源利用率并最小化成本。

- 企业级安全:通过基于角色的访问控制 (RBAC)、安全的云端或本地数据湖访问以及 JWT 身份验证确保安全的模型部署,以实现实时服务。

计算 (Compute)

简化维护并最大化资源利用率

ClearML 计算通过抽象工作流程和自动化资源分配,简化了计算基础设施的管理。它减少了开销,确保了高效利用,并在本地、云端和混合环境之间提供了灵活性,帮助团队轻松扩展。

- 降低开销并优化成本:全面了解基础设施使用情况,并自动化耗时任务以减少运营开销。轻松管理 Kubernetes、云和混合设置,有效控制成本。

- 简化访问并最大化资源利用率:通过自动化凭证管理和受控工作流程,普及对计算资源的访问,确保资源得到充分利用,并可供所有利益相关者访问。

- 启用混合且可扩展的计算模型:结合本地和云资源,避免供应商锁定,轻松扩展能力以匹配预算和性能需求,同时确保集群可用性和性能。