ClearML 为云服务提供商提供基础设施,以提供额外的 AI 服务

我们提供 AI 软件堆栈,您提供计算硬件

ClearML 提供了一个云原生基础设施解决方案,用于 GPU 即服务。云服务提供商 (CSPs) 和电信公司现在可以使用 ClearML 的白标版本,大规模实现端到端的 AI 采用和开发。通过先进的集群管理和增值 AI 服务,复制 Sagemaker 和 Azure ML 等超大规模厂商解决方案的成功。ClearML 的交钥匙解决方案扩大了您组织的 AI 服务产品组合,并在工业规模上最大化计算基础设施的利用率。

构建您自己的 AI 即服务的优势

提供一个完整的、白标的 AI 开发工作台

对整个云价值链拥有更多控制权

维护并扩展 B2B 客户关系

增加 AI 驱动的业务

弥补因竞争对手而损失的收入

提供 GPUaaS 并实现端到端 AI 采用与开发

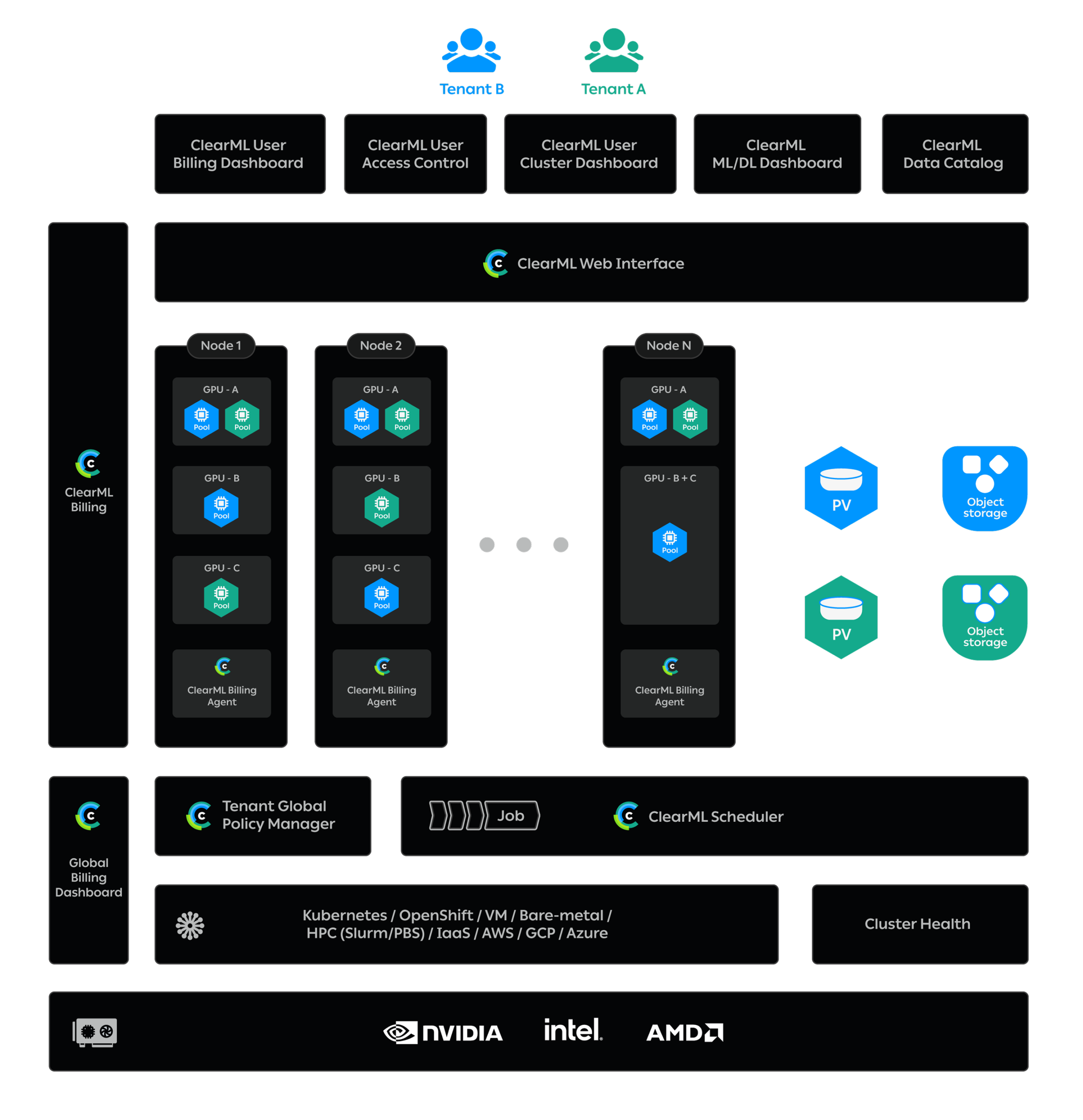

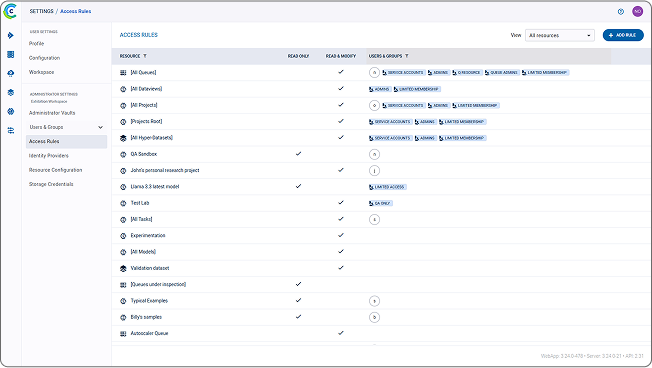

ClearML 的 GPU 即服务使云服务提供商和电信公司能够在共享计算资源上提供安全的多租户,用于密集的实验、训练或定制模型推理。ClearML 提供简化的账户管理和 AI 基础设施支持,用于管理多个租户和计费,并最大化计算利用率、治理和管理。计算提供商可以降低客户获取成本,并通过接近零的边际扩展成本提高客户生命周期价值。

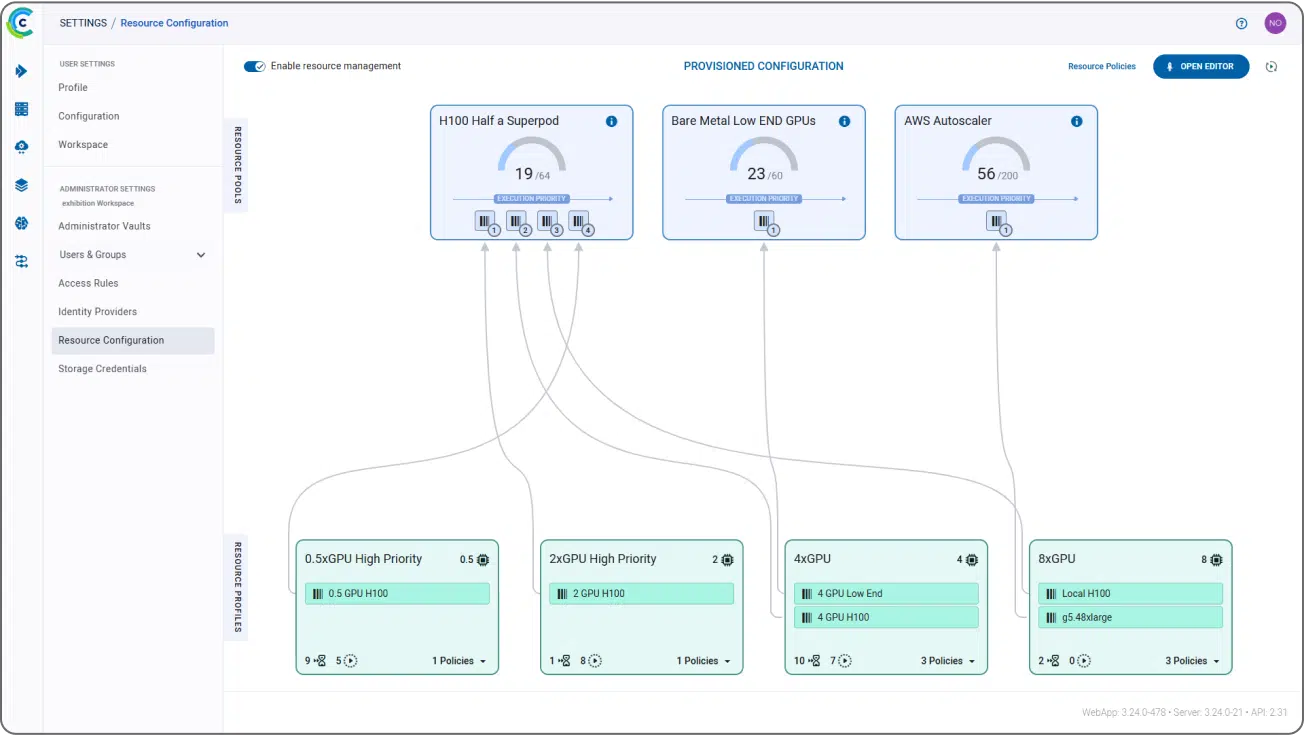

ClearML 灵活的开源基础设施控制平面允许对用户资源分配进行细粒度控制,以管理在 Kubernetes、Slurm、PBS 或裸机(或混合)上运行的计算集群,包括整个或部分 GPU。除了完整的端到端 AI 开发和部署平台外,ClearML 还提供集成且安全的计费功能,可根据实时使用情况开具准确发票,提供了完整 AI 即服务产品所需的全套工具。云服务提供商和电信公司现在可以对云价值链获得更多控制权,维护并扩展 B2B 客户关系,并弥补因竞争对手而损失的收入。从数字分销商转变为生态系统协调者。

适用于任何云服务提供商的完整超大规模 AI 堆栈

轻松增加 AI 收入并扩展您的服务

在您的计算资源上安全地提供多租户

轻松管理多租户账户

基于实时使用情况开具准确账单

提供附加服务

70%

生产时间减少 70%

5 倍

硬件利用率提高 5 倍

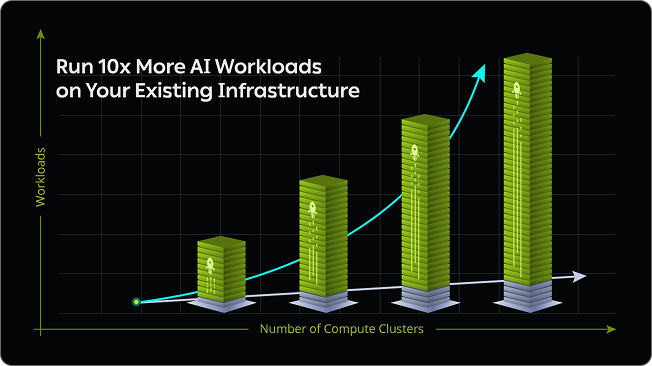

10 倍

在现有基础设施上运行 10 倍的 AI/HPC 工作负载

充分利用您的计算基础设施处理 AI 工作负载

通过接近零的边际扩展成本,降低客户获取成本并提高客户生命周期价值。随着 AI/HPC 工作负载对 GPU 需求(和价格)的上升,ClearML 提供了多种方法来最大化您的计算投资。设置高度细粒度的资源分配策略,指定每个团队应使用哪些资源,以及他们访问这些资源的优先级,无论是否具有超额配额能力。构建针对不同类型 AI 和 HPC 工作流优化的节点池和队列,并启用动态调度和 GPU 分片,为用户提供大小合适的环境,从而优化基础设施利用率。

按需运行您的 AI 基础设施

享受使用市场上最灵活的 AI 基础设施管理解决方案的自由。为您的客户提供与第三方对象存储集成或通过虚拟机访问计算资源的能力。ClearML 是硬件(和云)无关的,能够优化 Kubernetes 部署或通过 Slurm、PBS、LSF 或裸机运行作业。我们的开源特性使集成变得简单,并且我们的基础设施管理兼容所有主要 GPU 制造商。无论您运行什么,我们现在和将来都能管理它。

为您的客户实现更好的 AI 开发和采用

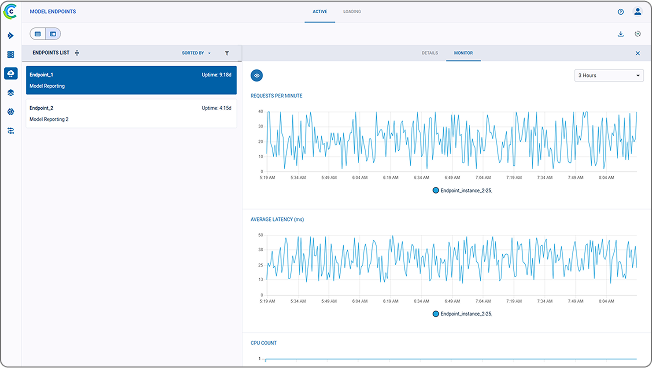

在您的计算和 AI 基础设施能力之上,提供 ClearML 的 AI 平台作为一个完整的端到端开源 MLOps 平台,以加速 GPU 密集型 AI 开发和部署。ClearML 的端到端解决方案使 AI 开发者能够仅用 2 行代码轻松构建、训练和大规模部署 AI/ML 模型,并为客户提供无摩擦、可扩展的方式,使其整个 AI 生命周期从实验室到生产环境在您的共享 GPU 池上无缝运行。

维护绝对的数据安全和隐私

ClearML 不会改变或影响您与客户的数据合规状态。该平台从不直接查看或访问客户数据,而是通过使用抽象元数据启用 AI 工作流。客户的实际数据保存在安全的存储中,并由计算资源直接获取。

ClearML 提供