最大化您的AI投资

利用ClearML,从您的基础设施中获得更多价值

在每个业务部门都需要更多GPU来应对AI和HPC工作负载需求的时代,ClearML通过其全新的GPU即服务解决方案,为企业提供了一个强大的数据中心级解决方案,用于优化计算基础设施。该方案提供了安全的多租户、细粒度的资源分配管理和策略、动态分块GPU、治理以及实时的使用情况报告。

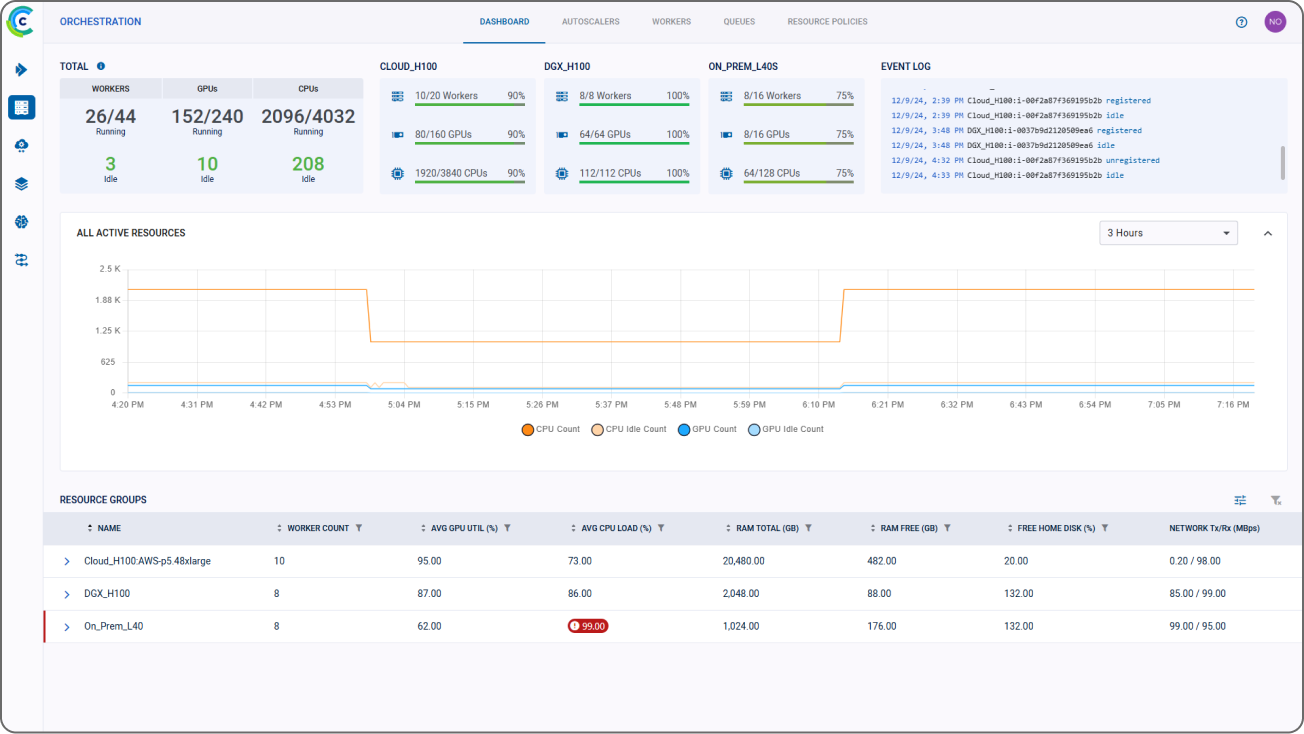

借助ClearML,AI基础设施负责人可以通过密切监控和控制资源使用情况,确保最昂贵的计算集群始终得到充分利用,并能够发出准确的内部计费回溯,反映计算小时、数据存储、API调用及其他可计费指标,从而从现有硬件投资中提取更多价值。

加速AI生产

消除计算浪费并实现端到端AI采用和开发

ClearML的端到端AI平台专为最复杂、要求严苛的环境和新颖的企业用例而构建,位于您现有计算投资之上,并加速利益相关者进行GPU密集型AI开发和部署。我们的开源、端到端架构为企业提供了一种无摩擦且可扩展的方式,使其能够在共享的GPU池上无缝运行整个AI生命周期——从实验室到生产环境。

通过易于管理的多租户功能,让多个团队访问相同的基础设施并运行安全、并行的AI/HPC工作负载,从而最大限度地利用您的计算资源。通过实时跟踪计算消耗、数据存储及其他指标并发出准确的费用回溯来控制成本。用于最大化计算利用率的其他功能包括GPU切片以及支持层级、优先级和配额的细粒度资源分配策略,以进一步确保计算资源不会闲置或未得到充分利用。

为您的AI计算投资设定更高目标

提高AI生产力。实现持续投资回报

通过无摩擦AI开发,加快生产上线速度

通过在ClearML的端到端开源AI平台上进行无摩擦的模型开发,提高跨团队生产力。团队可以在全球任何地方,无论是在办公室还是远程,在任何计算基础设施上协作共享数据并构建AI/ML模型。通过无缝的CI/CD轻松进行模型部署和监控,确保维护工作量最小。赋能您的AI组织,使其能够构建、训练和部署机器学习模型和LLM应用,以解决工业规模的内部用例。

通过从每个GPU中提取更多价值来提高投资回报率

利用分块GPU在单个资源上并行运行更多AI工作负载。通过硬内存限制进行隔离和保护,AI团队可以增加正在开发的项目数量并提高AI吞吐量。ClearML的自动化动态GPU切片确保工作负载以最有效的方式运行,并使用大小合适的容器,使AI基础设施团队能够轻松地在不增加额外成本的情况下提高生产力。

构建面向未来的AI基础设施

硬件和芯片无关性,实现灵活的未来增长

通过ClearML,您可以享受市场上最灵活的AI基础设施管理解决方案带来的自由。AI开发是持续进行的,独立于硬件、云和GPU采购,使AI基础设施负责人拥有完全的灵活性和自由度,可以构建、组合或添加不同GPU类型、环境或位置的计算集群。无缝支持您不断增长的AI/HPC工作负载需求。ClearML的开源架构实现了与您现有AI系统、基础设施、框架、模型、计算供应商和首选工具的互操作性和轻松集成。

改进AI工作流程的治理和控制

使用ClearML,您的AI工作流程的活动和访问是可见的、可审计的,并且易于治理和运营监督。我们采用SSO认证和LDAP集成的企业级安全性,确保对数据、模型和计算资源的访问仅限于经批准的用户和团队,从而对内部资产进行细粒度控制。所有数据版本控制、训练和实验的活动都被完整记录和跟踪,因此您可以在一个记录系统中更快地构建模型、轻松微调LLM并自信地开发生成式AI应用程序。通过提高可见性并加强AI团队间的协作和数据共享,确保业务连续性。

企业级安全性、数据隐私和内部业务数据保护

ClearML遵守您现有的所有数据隐私标准和协议。我们的平台实施基于角色的访问控制,并通过使用抽象的元数据来启用AI工作流程,绝不会直接看到或接触您的实际数据,实际数据由计算资源直接获取。平台中捕获已完成训练或推理工作流程的指标,但数据和结果直接发送到您的安全存储中。

70%

生产上线时间减少70%

5倍

硬件利用率提高5倍

10倍

在现有基础设施上运行10倍的AI/HPC工作负载