更快地构建更智能的 AI 工作流程

加速模型开发和部署流程,同时保持 IT 对 AI 生命周期进行控制。IT 部门可以建立具有分层结构和逻辑的强大资源分配策略,使 AI 构建者能够轻松启动远程会话,并利用 ClearML 的作业调度程序在经批准的计算资源上进行自助任务管理。我们的硬件无关架构支持跨各种集群类型(包括 Kubernetes、Slurm、PBS 和裸金属设置)进行模型训练、微调和部署,同时确保与 NVIDIA™、AMD™、Arm™ 和 Intel™ 等各种硬件平台兼容。

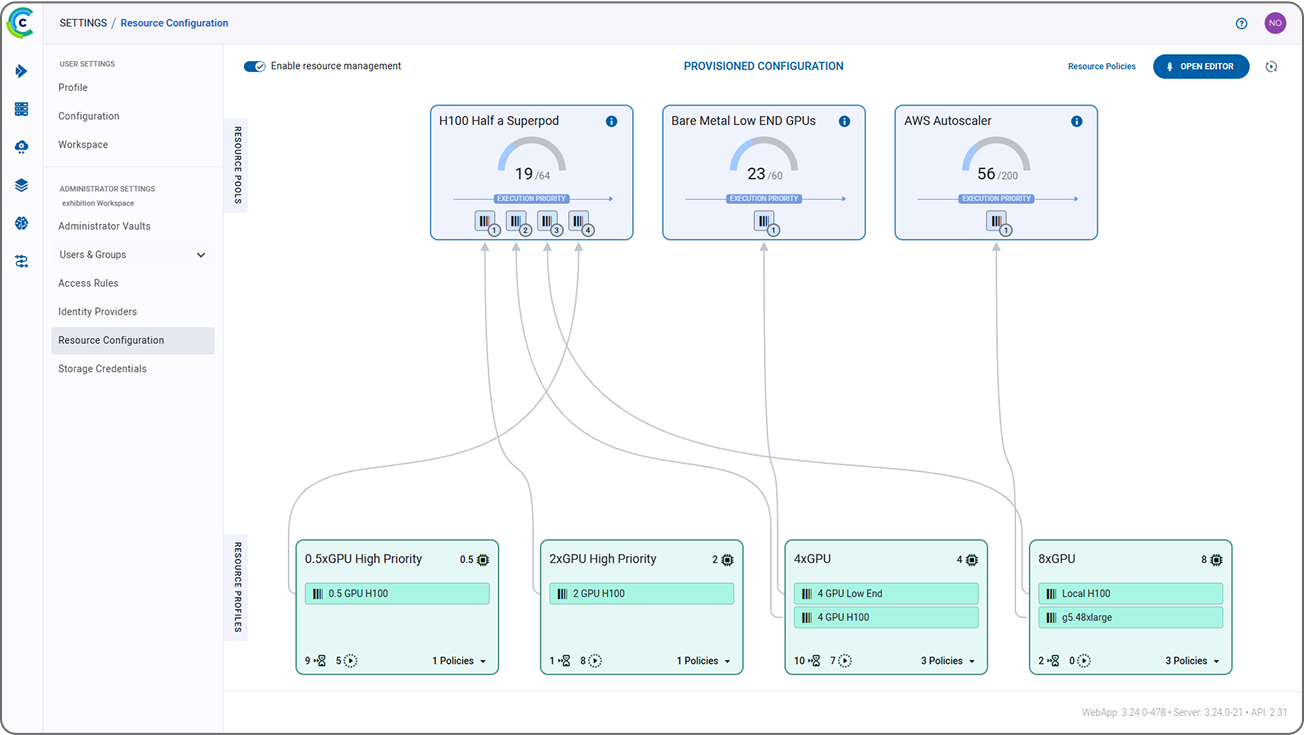

资源分配策略管理器

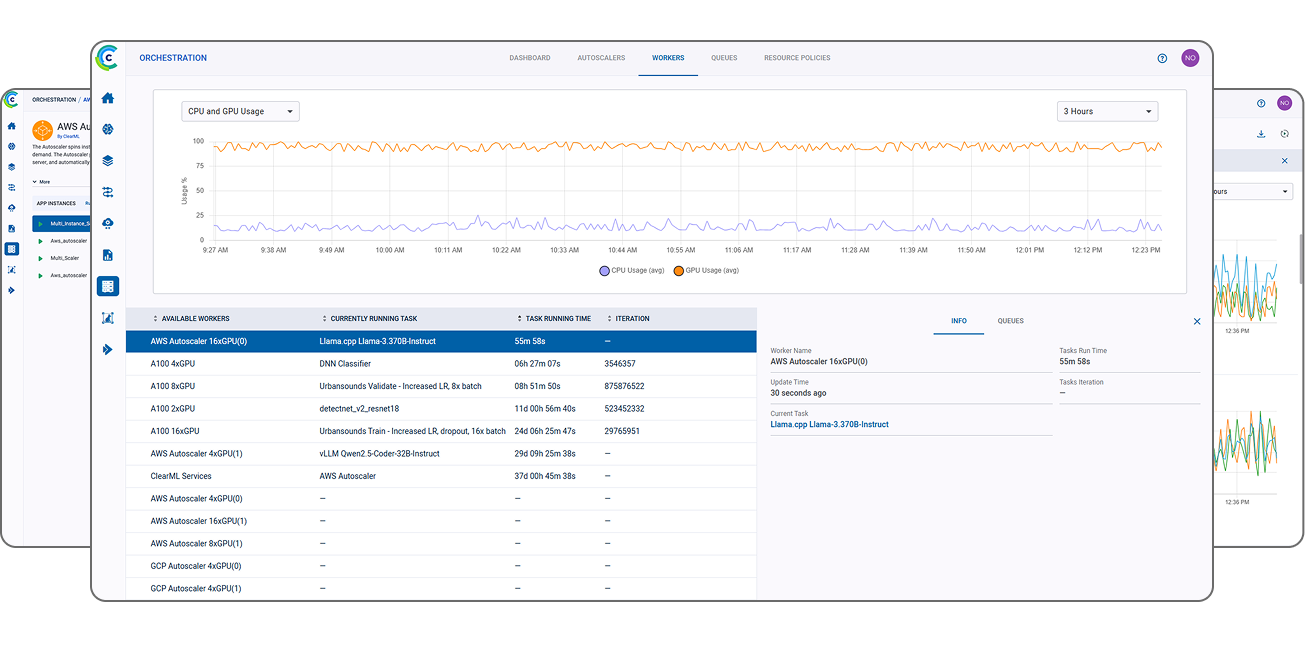

全面了解您所有的计算集群及其使用情况

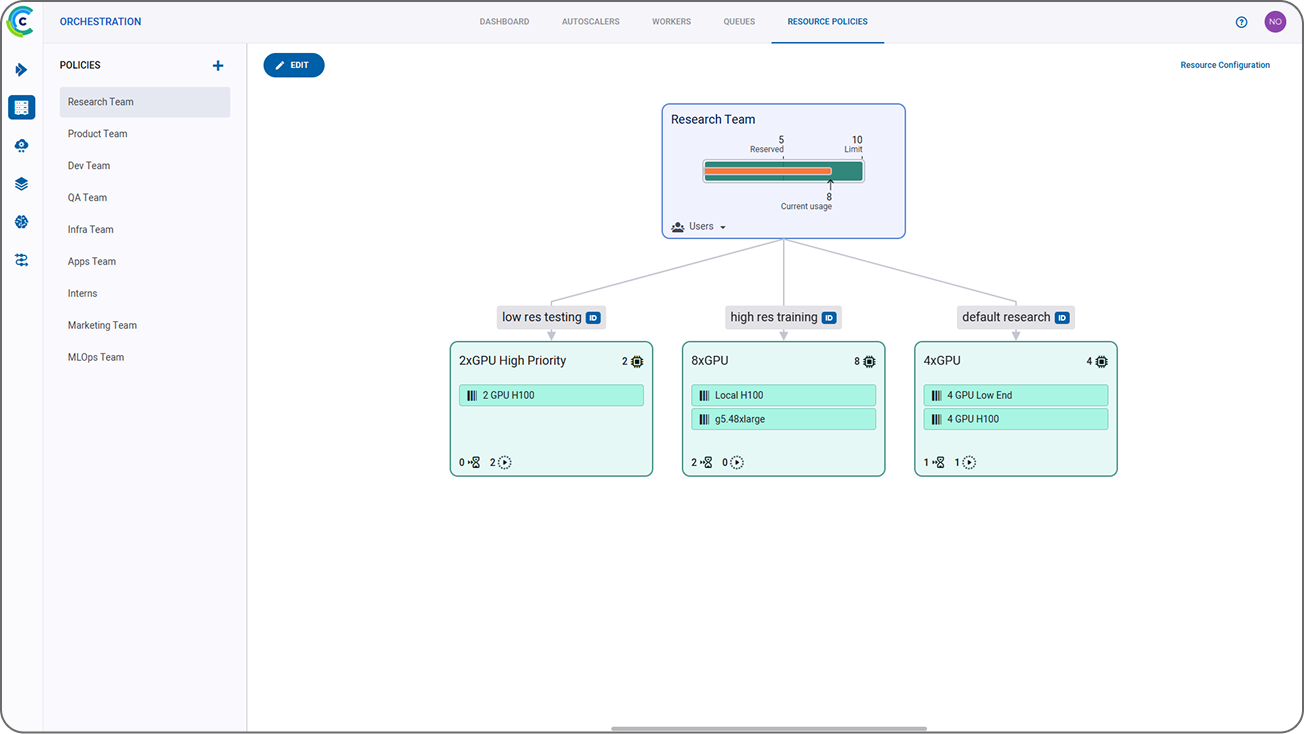

ClearML 的资源分配策略管理器简化了资源分配,并允许管理员有效地优先处理资源并实时监控团队使用情况。它最大程度地提高集群利用率,并在资源需求紧迫等情况下提供灵活性,通过允许管理员定义配额并保证每个团队的计算能力。这确保了每个团队都能获得他们所需的计算资源,同时简化了动态需求管理流程。

- 全面可见性:ClearML 资源分配策略管理器提供所有可用资源的全局视图,显示跨团队的配额分配。凭借这种可见性,管理员可以设置优先级,以确保集群实现负载均衡,或优先使用更新、更快或本地的机器,从而降低运营成本。

- 最大化利用率:管理员可以为项目和团队设置配额和超配额,这样他们就可以访问空闲机器,即使这些机器已经预留给其他人。通过防止机器闲置,组织可以最大化其投资价值。

- 无需停机即可添加或移除集群:管理员可以轻松添加新集群或使现有集群脱机,而不会影响 AI 构建者。通过确保团队和项目始终映射到可用资源的能力,IT 可以在不影响 AI 开发的情况下进行基础设施维护。

自助计算

赋能 AI 构建者,推动更快速的开发

- 效率和可扩展性:自助计算通过让 AI 构建者直接访问资源来消除瓶颈,而编排则动态分配预先批准的资源用于任务。

- 流程简化:将编排与已建立的资源策略和存储的凭据集成,消除了手动配置的需要,从而能够更快地进行 AI 模型原型设计和部署。

- 降低开销:消除手动配置的需要降低了 IT 团队和管理员的开销,使他们能够专注于更高价值的任务。

作业调度

优化和简化 AI 工作负载处理

- 优先作业管理:构建并监督优先任务队列,以实现有效的资源分配。企业客户可以通过分片 GPU 和团队专属资源限制等高级功能提升 GPU 利用率。

- 资源跟踪和工作负载均衡:按用户组或队列观察 GPU 和 CPU 消耗情况,并轻松地在机器之间重新分配任务或扩展资源以满足处理需求。

- 超配额利用:利用超配额功能充分利用空闲资源,即使在高需求时期也能确保资源得到充分利用。

高性能计算兼容性

查看您的 Slurm 和 PBS 集群内部正在发生的事情

- 全面了解您的 HPC 集群:ClearML 使您的 Slurm 和 PBS 集群透明化,允许您监控这些集群上的所有作业,了解每个作业使用的资源,并访问聚合结果。

- 开箱即用的自动化:您可以在 ClearML 上编写自定义代码,或使用我们内置的管道和任务调度功能创建自定义自动化,而无需借助于 Bash 脚本。

- 异构集群:借助 ClearML,创建和维护异构集群变得更加简单。ClearML 可以通过云溢出以及 AWS、GCP 或 Azure 的自动伸缩器将您的 HPC 计算扩展到云端。

交互式开发环境 (IDEs)

一键启动 IDE,随时随地工作

- 灵活开发:无论您身在何处,只需单击一下即可在任何远程机器上启动 JupyterLab、VS Code 或 SSH 会话。

- 工作区同步:自动存储和恢复交互式会话工作区,以实现跨会话的连续性。

- 安全协作:通过加密连接安全地访问远程资源,确保无缝的团队协作和资源共享。

控制和优化您的整个 AI 计算基础设施

借助基础设施状态和性能的完整视图,轻松监控和管理您所有的 CPU 和 GPU 集群。启用安全的共享计算和动态分片 GPU,以精确控制在每个 GPU 上运行多个作业,从而提高利用率。通过资源池化、应用配额(具备超配额能力)以及有效分配本地和云资源来提高可访问性,从而控制云支出。

安全多租户

通过安全的共享计算提高集群利用率

- 高效资源利用:多租户动态重新分配未使用的资源,实现硬件利用率最大化。

- 可扩展性:此功能允许通过添加集群或云提供商来无缝扩展基础设施,而不会中断现有工作负载。

- 增强安全性:隔离网络提供数据隐私并防止跨租户干扰,保护敏感项目。

动态分片 GPU

充分利用您已有的 GPU

- 高效资源利用:动态分片 GPU 允许多个工作负载共享单个 GPU,确保 GPU 资源得到充分利用,避免空闲或浪费。

- 节省成本和延迟额外 GPU 购买:通过优化 GPU 使用并在同一硬件上运行多个任务,组织可以减少维持 AI 开发所需的 GPU 数量,从而显著降低成本或延迟额外 GPU 的购买。

- 灵活性和可扩展性:动态 GPU 分配可根据不断变化的工作负载需求进行无缝调整,以改进的可扩展性支持 AI 开发和部署。

多云/多集群

以最有效或最经济的方式构建您的基础设施

- 灵活性:ClearML 的云无关设计支持多云部署(AWS、Azure、GCP),并与 Kubernetes、Slurm/PBS 和裸金属集群集成,以实现多样化的基础设施兼容性。

- 集中管理:提供集中式控制平面,通过详细的仪表板和精细控制来监控、分配和优化多个集群中的资源。

- 可扩展性:通过分片 GPU、分层配额/超配额和混合云溢出等功能,动态地在异构集群上扩展工作负载,以最大化资源利用率。

云溢出

最大化现场基础设施使用,减少不必要的云支出

- 策略驱动的资源分配:通过 RBAC 设置访问规则,确定何时应使用云资源,例如在本地基础设施处于最大容量的繁忙时段。

- 轻松云集成:借助 ClearML 流畅的调度和编排功能,自动启动云实例以处理额外的工作负载,而不会中断任务或用户。

- 云成本控制:优化云使用以管理费用。为云资源访问建立指导方针和限制,并为单个项目或团队分配云预算,以实现精确的使用监控。

自动伸缩器

根据需要自动启动和关闭云实例,以管理云成本

- 轻松云扩展:轻松将 AWS、GCP 或 Azure 的计算资源集成到您现有的基础设施中,并设置策略以确定何时可供项目和团队使用。

- 消除闲置实例:自动化云机器的伸缩,最大化效率,消除闲置资源上的不必要费用。

- 灵活的混合模型:动态地融合本地和云资源(Kubernetes、Slurm、裸金属),创建强大的混合计算解决方案,在不受限于单一供应商的情况下提供可扩展性。

最大化 AI 性能并最小化成本

资源仪表板

监控您的基础设施的统一视图

- 实时可见性:管理员可以即时了解集群性能(可用资源与已用资源)和团队配额使用情况,以便在资源分配方面做出更好的决策。

- 性能:仪表板提供每个资源的队列视图,以及资源随时间的使用情况、事件历史日志和详细的性能指标。

- 有效资源管理:组织可以监控利用趋势,强制执行计算使用,并关联预算以优化资源分配。

使用报告

获取用户活动的实时报告

- 用户活动跟踪:ClearML 的详细报告有助于跟踪使用情况,以准确反映计算时数、数据存储、API 调用和其他可计费指标的实时消耗。

- 改进资源分配:通过精细的洞察和趋势更好地预测计算需求。实现更好的工作负载分配,确保 GPU 既不空闲也不过载。

- 透明度和问责制:组织可以使用使用报告进行内部计费,并在共享环境中监控特定租户的资源消耗。

配额管理

控制计算消耗,同时确保高利用率

- 公平资源分配:配额确保没有任何一个团队或项目垄断集群资源,促进所有用户的公平访问。

- 提高利用率:通过重新分配闲置资源,配额管理最大化集群运营效率,减少浪费。

- 可扩展性和灵活性:配额可以动态调整资源限制,使集群能够随着工作负载的发展无缝扩展。

云资源预算控制

通过高效的云使用最大化您的云预算

- 运营费用可预测性:设置云限制,确保计算消耗不超过分配的预算,避免意外成本。

- 减少闲置资源上的支出:在预设的空闲期后自动关闭云实例,消除在闲置实例上的不必要支出。

- 优先使用本地资源:创建资源分配策略和规则以优先使用本地资源,仅在本地基础设施满负荷时才溢出到云端。

优化您的基础设施以支持 AI 工作负载

ClearML 的 AI 基础设施控制平面为简化用户对资源的访问提供 AI 编排能力,为确保计算集群的充分利用提供 计算优化能力,并为最大化基础设施投资回报率提供 成本削减能力。