Nate Fung,Cisco Meraki 机器学习工程师

Cisco Meraki 是一家云管理 IT 解决方案公司,提供设计用于简化、可扩展性和集中管理的网络、安全和物联网产品。作为 Cisco 的子公司,Meraki 提供一系列硬件和软件解决方案,包括无线接入点、交换机、安全设备(防火墙)、智能摄像头和终端管理工具——所有这些都通过基于云的 Meraki Dashboard 进行管理。

Meraki 被企业、小型企业、学校、医院和政府广泛使用,通过零接触部署和自动化来简化 IT 运营、增强安全性并提高网络性能。这是他们如何使用 ClearML 的故事。

Meraki 一直在使用 ClearML 管理其在本地和云端运行的 AI 项目的实验和工作流自动化,例如计算机视觉和自然语言理解的 LLM(大型语言模型)研究,以及创建工作负载用于评估模型性能和自动化 RAG(检索增强生成)流程。

我们发现 ClearML 有助于我们改善团队间的协作,从而加速 AI 开发,并简化用于生产的实验和 CI/CD(持续集成/持续部署)管道的工作流自动化。

这样做,我们看到了积极的影响,越来越多的团队正在开发 AI 功能,并且通过有效利用我们的计算资源,自动化和可扩展的 ML(机器学习)工作流的开发速度更快了。

使用 ClearML 之前的挑战

AI 开发正在 Meraki 的许多团队中扩展。研究人员正在发现使用 AI 的创新解决方案,产品团队正在将 AI 功能集成到他们的产品中,而平台和分析团队则使用数据和高级分析来制定业务决策并提高运营效率。

一些团队发现启动他们的 AI 项目和使用他们的数据进行实验具有挑战性,因为他们不知道使用哪些工具或如何管理它们,与此同时,其他团队管理自己的工具并拥有他们想要继续改进的流程。

一些团队仅限于在他们的个人计算机上运行实验,并希望轻松访问更大的计算资源,与此同时,其他团队已经拥有强大的本地计算资源的专业设置或定期使用基于云的计算资源。统一所有这三类资源对于易于访问和提高运营效率非常重要。

为了弥合我们团队之间的差距,我们相信一个带有工具的集中式 ML 平台可以帮助标准化使用、减少重复工作并具有简单的学习曲线,这将使他们能够更容易地启动并继续推进他们的 AI 项目。

Kubeflow 是一个曾尝试过的解决方案,但其复杂性和维护带来了挑战。它需要专门的 DevOps 团队来管理,并且陡峭的学习曲线使得新用户难以入门。因此,我们转向了 ClearML,一个用于构建、训练和部署 AI/ML 模型的开源平台。

使用 ClearML,我们发现这些复杂性和学习曲线大大降低了。它与我们的 AWS 基础设施无缝集成,开箱即用。它满足了许多要求,包括针对本地和云端项目的强大实验跟踪、数据集管理、工作流自动化以及 CPU 和 GPU 资源管理。它是一个出色的 ML 平台解决方案,可以支持我们不断增长的 AI 项目数量。

聚焦 ClearML 的特定功能

例如,能够轻松跟踪和监控本地和云端的实验是我们的一项关键功能,因为一些团队拥有专业环境,而另一些团队则需要通过自动扩展运行工作负载的便利性。

实验跟踪有助于提供一种结构化的方式来比较实验中的试验,以指导和推进项目的研究策略,例如更好地理解哪些超参数对模型精度影响更大以及如何优化模型和实验。只需几行代码,我们就可以立即开始监控现有的本地实验,只需一个 API 调用,我们就可以在具有更大计算和内存资源的远程工作器中运行整个实验。ClearML 使协作和共享每个试验的指标和工件变得更加容易,因为它们都集中在同一个项目文件夹中并与其 ClearML 任务相关联。

工作流自动化改进了我们的 MLOps 过程,并使我们的用户能够创建可扩展的工作流。只需几个简单的 CLI(命令行界面)命令,用户就可以在远程工作器上运行他们的工作负载,而不必总是担心设置 Docker 容器或配置计算资源,因为 ClearML 为我们管理了大部分工作。

例如,数据科学家可以快速原型化他们的工作流,以便在将工作流投入生产和优化时与 ML 工程师更有效地协作。凭借自动扩展、管道和 CI/CD 集成的灵活性,原型化用于概念验证 (PoC) 的 ML 工作流,然后将其扩展到生产工作负载变得更加精简。资源管理帮助我们有效利用 CPU 和 GPU 资源,并允许团队在一天中的任何时间进行开发。

编者按

ClearML 自动扩展器根据需要启动额外的云计算资源,并在最少额外工作量的情况下补充现有基础设施。用户可以在现有计算基础设施(裸机、Kubernetes、云或混合)之上添加来自 AWS、GCP 或 Azure 的额外计算资源,几乎没有额外的开销。当不再需要额外的计算资源时,ClearML 自动扩展器会将其关闭以控制成本。

ClearML Pipelines 使客户能够将 ClearML 任务连接成自动执行的管道,并在任务之间添加自定义逻辑。它简化了管道内不同 ClearML 任务之间的数据移动。ClearML Pipelines 的构建使得不同的任务可以在不同的计算资源上运行,从而优化计算资源分配给特定的任务。

ClearML 团队通过 Slack 提供了出色的支持,他们乐于助人且响应迅速。与我们自己的 AWS 基础设施的设置和集成非常顺利。

以下是我们团队的一些感言

“到目前为止,ClearML 给我留下了深刻的印象——它是一个令人惊叹的平台,拥有许多很棒的功能。以下是让我印象深刻的一些功能:

- 日志记录:日志记录仪表板非常有用。它们不仅允许我们展示实验结果,还可作为产品团队更好地理解我们工作的宝贵参考。

- 比较工具:并排比较不同实验的能力对于分析我们的模型和算法非常有价值,特别是结合详细的日志页面时。

- 管道:虽然我们尚未完全发挥此功能的潜力,但它是一个强大的工具,我们计划用它来自动化训练和测试流程,增强信息流的可见性,并组织我们目前分散在不同 GitLab 管道中的工具链。

- 文档和支持:文档非常棒,支持团队也做得非常出色。

总的来说,使用它非常棒。”

“ClearML 实际上对我们的团队来说是一项巨大的资产。其中一个重要的亮点是它如何帮助我们稳定并跟踪我们的数据集的多个版本;这确保我们清楚地知道哪个数据集版本对应哪个实验,从而使整个工作流更加可靠。我们也非常赞赏 ClearML 在模型训练方面的实验跟踪能力。比较不同模型版本、随时间监控训练演变以及使用一致的集中式指标评估性能都变得非常简单。能够快速查看超参数或数据的变化如何影响结果为我们节省了大量时间。”

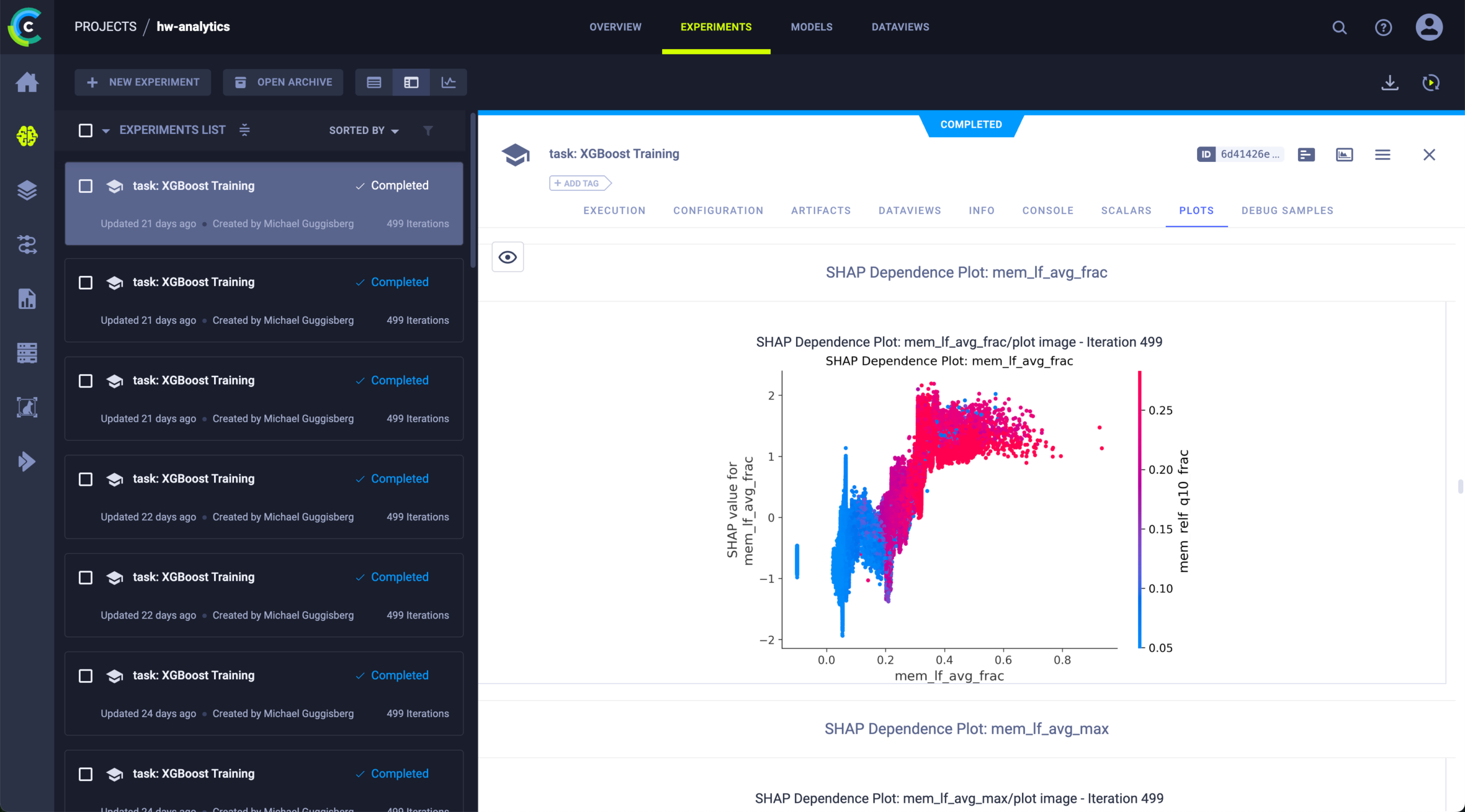

图 1:硬件分析团队在 ClearML 中训练模型并使用 SHAP 值进行可解释性分析

展望未来

ClearML 通过提供全面的实验跟踪和工作流自动化,帮助我们克服启动 AI 项目和推进现有项目的障碍。借助 ClearML,我们能够改善 Meraki 许多团队的 AI 开发,从而更有效地实现我们的 AI 愿景。

如果您想了解 ClearML 的实际运行情况,请申请演示并与我们的销售团队人员交流。