作者:John Lambert,开发者;Matthew Shannon,开发者;JoEllen Magnus,业务分析师,SIL International

客户概览

在 SIL International,我们服务于世界上的每一个语言社群,帮助人们使用他们最珍视的语言蓬勃发展。九十多年来,我们一直致力于识别和分类世界各地的 7000 种语言。SIL 的团队孜孜不倦地记录这些语言,教授识字,并用他们的语言向社区提供基督教经文。我们的语言学、识字和翻译工具被学术界和圣经翻译组织广泛使用。

在过去两年中,SIL 的团队一直在使用 ClearML 来组织众多 AI 工具的研究工作,包括构建定制化的、经过微调的翻译模型,以服务于各个语言群体。ClearML 是帮助我们运行和组织实验的关键。在成功试运行后,我们于 2024 年初推出了一个生产级自助AI翻译服务。

挑战

虽然 ClearML 能够出色地处理我们的研究实验,但我们担心 ClearML 在生产需求方面的表现。正常运行时间、API 稳定性以及快速的用户支持立即成为首要任务。

关于正常运行时间,我们的本地 GPU 服务器具有成本效益,但缺乏冗余使得我们的 AI 工具容易受到潜在中断的影响。服务器故障或德克萨斯州的飓风可能导致我们的服务停机一周或更长时间。我们需要一种解决方案,它无需购买另一台服务器并将其安置在另一座城市,也无需为我们不使用的云服务付费。我们还需要一种解决方案,在深夜发生故障时无需工程师手动干预。最后,如果我们的单一服务器因用户请求过多而超载,我们需要一种能够扩展的解决方案。

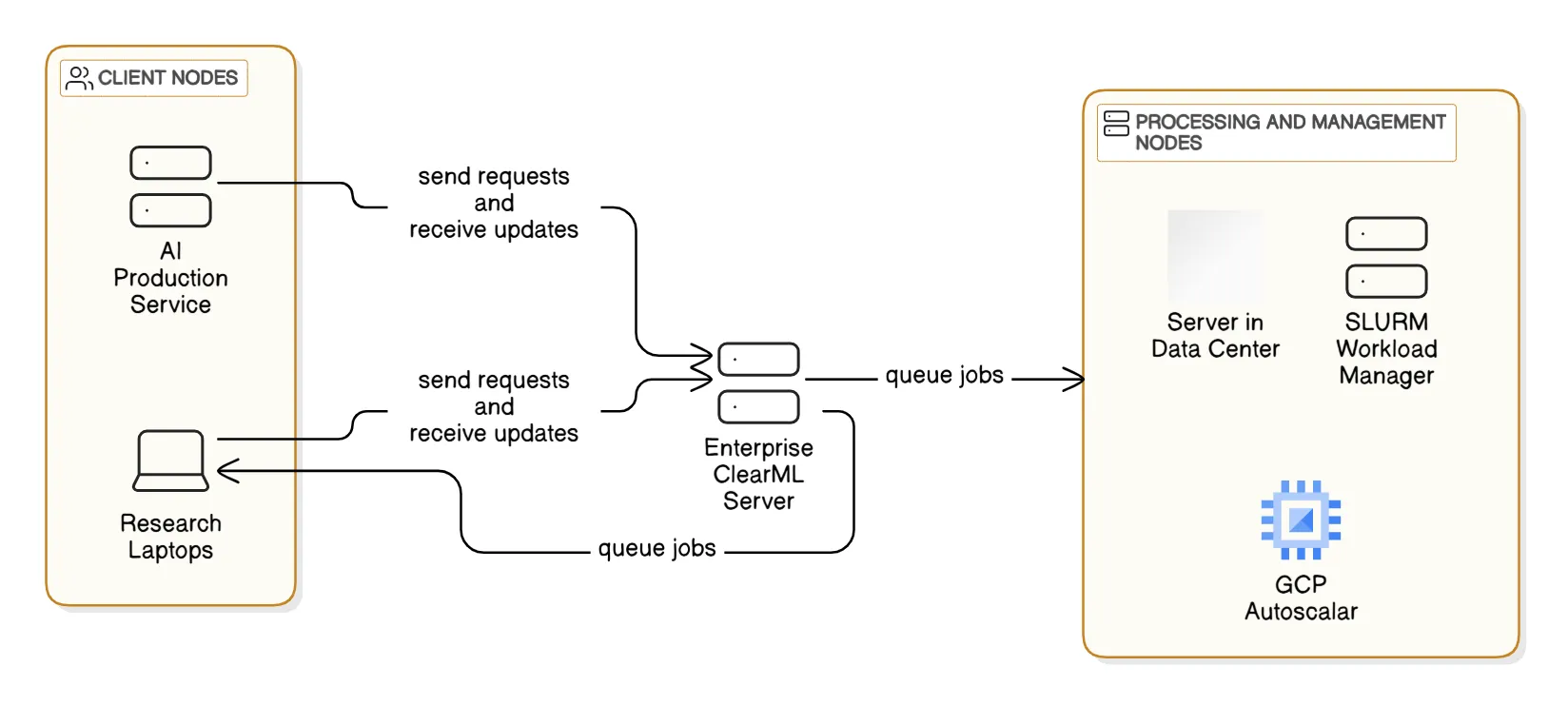

除了这些担忧之外,我们的 GPU 资源也变得越来越多样化——包括我们的中央服务器、用户配备 GPU 的 Windows 笔记本电脑以及借用的 SLURM 集群。尽管由于特定要求,只有中央服务器可用于生产负载,但我们希望所有资源都能用于研究和开发。

解决方案

通过 ClearML,我们将我们具有成本效益、可靠性较低的本地 GPU 服务器与 通过 Google Cloud 使用的 ClearML 自动伸缩器结合起来,这样就只在我们真正需要时才为高可靠性 GPU 付费。

一个关键功能是我们能够优先使用我们的数据中心 GPU。只有当队列深度超出我们的设定时,队列才会将作业发送到自动伸缩器。ClearML 最初发布的自动伸缩技术没有此功能。当我们联系 ClearML 询问此功能时,得到了迅速而令人满意的答复:ClearML 刚刚添加了 Policy Manager 功能,可以满足此功能需求。

我们安排了一次会议,进一步讨论我们的用例。在不到一周的时间里,ClearML 就将我们的服务器升级到了最新的企业版,从而启用了我们所需的自动伸缩器功能。ClearML 团队的快速响应和全面支持在整个过程中都表现出色。

至于我们多样化的研究硬件,ClearML 可以轻松地与每个系统对接,允许通用的 S3 存储桶访问并运行我们的研究流水线。我们正在利用 Docker 镜像进行生产环境的一致部署。我们的研究团队添加了 Conda 虚拟环境配置,以与 Docker 镜像一起确保一致性。这还有一个额外的好处,即可以在用户的笔记本电脑上更简单地运行。ClearML 在硬件和虚拟化技术方面的灵活性、可配置性和可靠性仍然是我们团队的核心资产。

至于我们多样化的研究硬件,ClearML 可以轻松地与每个系统对接,允许通用的 S3 存储桶访问并运行我们的研究流水线。我们正在利用 Docker 镜像进行生产环境的一致部署。我们的研究团队添加了 Conda 虚拟环境配置,以与 Docker 镜像一起确保一致性。这还有一个额外的好处,即可以在用户的笔记本电脑上更简单地运行。ClearML 在硬件和虚拟化技术方面的灵活性、可配置性和可靠性仍然是我们团队的核心资产。

成果

随着我们迈入 2025 年,我们的团队正积极为超过 300 个语言群体提供定制化的、经过微调的翻译模型支持。我们的主服务器主要致力于这些生产工作负载,并配有可靠的备份。在其他 GPU 资源得到良好整合的情况下,我们的研究工作也能全速前进。我们有能力持续扩展,并坚信借助 ClearML,我们当前和未来的生产与研究需求都能得到良好支持。