在进行机器学习操作时,可用的选项可能让人眼花缭乱。过程中的每一步都可能有多种解决方案,而最受欢迎的(通常是开源工具)可能不一定好用或易用,但它们是免费的 😁。然而,如果不是开源工具,集成方面就得受供应商的限制。在这篇博客文章中,我们将对 ClearML 与数据版本控制、实验管理以及调度和编排领域的其他特定解决方案进行高层次的比较,帮助您了解为什么 ClearML 是企业 MLOps 的最佳解决方案。

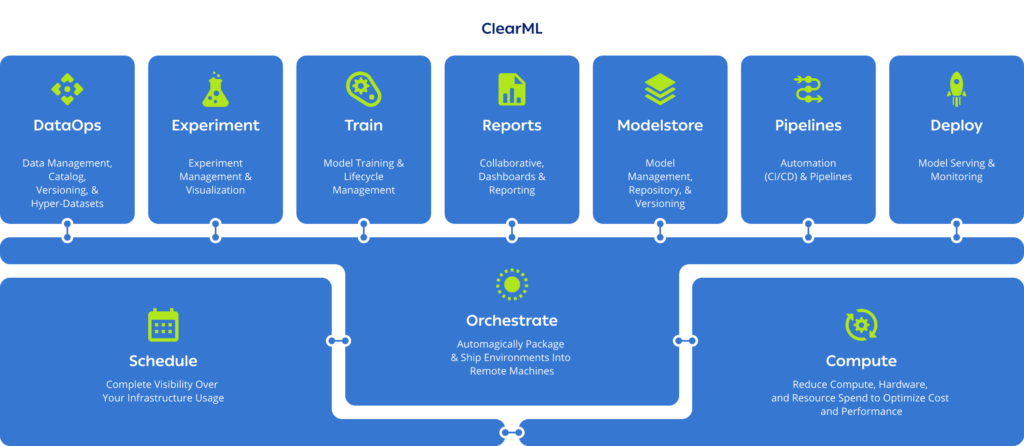

如果您不了解,ClearML 是一个统一的开源端到端平台,支持从研究到生产的整个 ML 生命周期。该平台的开放架构让您可以选择使用我们的最佳模块或替换现有的工具,从而轻松地接入并增强您现有的流程和系统。

ClearML 与数据版本控制解决方案

在 ClearML 上管理数据既轻松又简单。我们的自动化数据记录会跟踪每次运行的每一次更改,使任务可重复,而不会占用大量存储空间或管理大量凭据。内置于 UI 中的直观功能,例如标签、抽样和可视化,使理解和共享您的数据目录变得容易得多。ClearML 还提供了数据的完整谱系以及数据在任务和管道中的使用位置。数据配置完成后,任何拥有正确权限设置的人都可以从任何地方访问它。

与更大的 ClearML 持续机器学习平台连接后,您的数据会连接到实验和任务以及输出。通过运行克隆实验并进行微小的参数调整,实现完全可重现性并更快地迭代。

ClearML 旨在适应各种模型训练用例;然而,该平台在管理非结构化数据方面尤为出色。ClearML 在文件级别进行文件管理,这对于图像、音频、视频或文本文件来说非常棒,但我们也理解在处理表格文件(如数 GB 的 parquet 或 CSV 文件)时可能会带来一些挑战。

利用我们 Hyper-datasets 功能的企业客户可以访问优雅抽象的元数据,从而实现过采样和去偏差,而无需处理笨重的超大文件的困难。元数据和标注会自动版本化到数据库中,让您可以实时切分数据,并更改进入任务、实验、作业等的流式数据源。无论数据物理存储在何处(绝不在 ClearML 内部——我们只在后端服务器保留元数据),ClearML Hyper-datasets 都是使数据易于访问的强大工具。

ClearML 与实验管理解决方案

实验管理解决方案是当今市场上最常见的 MLOps 工具。虽然它们在界面、性能评估仪表板以及日志记录到云端或本地驱动器的不同默认设置方面存在表面差异,但当您尝试比较多次运行、更快地执行任务或处理超大数据集时,就会显现出巨大的差异。

从根本上说,ClearML 统一的 MLOps 平台使用 Python(不支持 R),并将编排连接到实验管理的每个部分,自动记录每次运行的配置、参数和设置,并通过自动捕获元数据和高级缓存促进整体更快地进展。实验可以立即重现,只需一次点击即可使用不同的参数再次运行。实时报告和共享也很容易。结果的实时图表可以嵌入 Notion 或 Confluence 等第三方编辑器中。

ClearML 的设计是为了让数据科学家和 ML 工程师的生活更轻松。构建管道非常直观,甚至可以说令人愉快。我们支持带有 RBAC 的项目层级结构,跟踪几乎所有内容(包括 git diffs),并允许您比较任意数量的实验。好吧,实际上最多只能比较 100 个实验,但如果这对您来说还不够,我们可以讨论一下 😉。虽然我们不能夸耀拥有最多的用户,但我们拥有(在我们看来)最活跃的社区成员群体,他们乐于分享想法或提问。

在 ClearML 上将训练好的模型部署到生产环境是无缝的,因为操作的所有部分在整个平台中都“讲相同的语言”。无需重新格式化或重新配置任何东西,建立真正的 CI/CD 反馈循环不仅是可能的,而且也很容易。您的 DevOps 团队会对此非常满意。

ClearML 与调度和编排解决方案

ClearML 的内置功能让您可以完全调度、编排和自动化您的机器学习工作流和管道,而无需支付任何其他软件费用。在 ClearML 上工作既简单又灵活——您可以直接从开发环境部署,并从任何地方(代码、CLI、Git 或 Web UI)启动到您的基础设施(云、本地、Docker、Kubernetes 或 Slurm)。您的基础设施可以是完全基于云的或本地的,这都没关系。ClearML 不受云平台限制,也支持在裸金属上安装(无需 Kubernetes)。

ClearML 消除了对每个作业进行容器化的需要,节省了时间、存储空间和存储成本。

构建透明、有优先级的作业队列,让团队成员可以查看当前工作的全貌,重新排序他们的作业,并更频繁、更轻松地进行协作。最大化您的计算资源利用率!ClearML 已获得认证可运行 NVIDIA AI Enterprise Software Suite,并允许客户充分利用 NVIDIA DGX™ 系统和 NVIDIA 认证系统™ 的 GPU 能力。利用 NVIDIA GPU 切分的新功能,每块 GPU 可创建多达 7 个分区,并为每个工作负载匹配正确的计算能力。容器可以访问分块和虚拟 GPU,允许不同的工作流在一块 GPU 上并行运行。所有功能开箱即用。

需要更多计算能力?ClearML 自动伸缩器让您可以根据需要启动或溢出 AWS、GCP 或 Azure 上的计算资源,并且可以使用团队级别的预算上限来控制使用。ClearML 使更多人能够以更少的开销访问计算能力。

通过 ClearML,管理员可以一次性设置用户的权限级别,无需为配置更多机器、管理凭据或跟踪计算资源使用情况而烦恼。我们的模块化架构和开源特性使得与其他工具的集成变得容易。总体而言,管理整个 MLOps 基础设施对您的工程团队来说负担大大减轻。

接下来的步骤

正如您所见,ClearML 使数据科学家、ML 工程师和 DevOps 能够在直观设计的单一开源平台上高效地进行机器学习和深度学习工作,它承担了所有繁重的工作。然而,是选择一个处理所有工作的一站式 MLOps 平台,还是选择许多专业工具,最终是您的组织需要做出的决定。选择权在您!如果您想开始使用 ClearML,请使用我们的免费层服务器或自行托管。在此阅读我们的文档。

您可以在我们的 YouTube 频道上找到更多关于 ClearML 的深度教程和精彩演示,我们还有一个非常活跃的 Slack 频道,为需要帮助的任何人提供支持。

如果您需要扩展您的 ML 管道和数据抽象,或者需要无与伦比的性能和控制,请申请演示。