现在,无论您的数据和计算资源位于何处,您都可以在本地或云端创建和管理您的控制平面。

我们最近宣布了广泛的新编排、调度和计算管理功能,以优化对企业 AI & ML 的控制。机器学习和 DevOps 从业者现在可以充分利用 GPU,以最低的成本实现最大使用率。现在,通过 GPU 分配/MIG 服务,多个工作负载可以根据优先级、时间片比例或硬性上限共享单个 GPU 的计算能力。使用这些功能的全球 ML 团队报告称,他们可以更好地控制计算成本和 GPU 利用率,同时加快上市时间、创收时间和价值实现时间。阅读新闻稿。

ClearML 的最新功能通过抽象基础设施复杂性并简化对 AI 计算资源的访问,弥合了机器学习团队与 AI 基础设施之间的鸿沟。客户现在可以利用业内最先进的编排、调度和计算资源管理功能,最大化 GPU 利用率并有效分配资源。这些增强功能包括:

最佳实用性

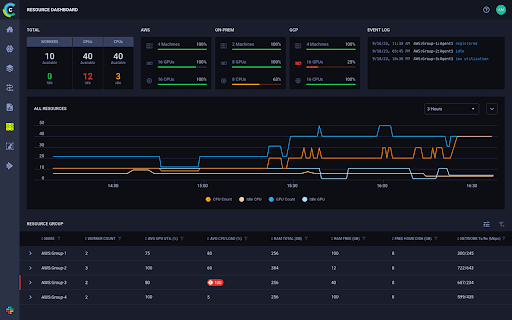

为了使客户能够更有效地可视化、管理和控制资源利用率,ClearML 推出了新的企业成本管理中心,该中心直观地向 DevOps 和 ML 工程师展示其 GPU 集群中发生的一切,并为团队提供了一种更好的方法来管理作业调度、最大化 GPU 分配和使用以及项目配额。

例如,公司将能够更好地了解他们在 NVIDIA DGX™ 或 DGX™ Cloud 机器上的 GPU 使用情况,从而最大化资源利用率并管理成本。此外,客户现在可以管理 GPU 资源的供应、拆分、调度、池化和使用。

从资源分配和预算的角度来看,GPU 管理对公司至关重要。通过池化或拆分 GPU 以在单个 GPU 上运行多个模型,公司可以更有效地服务最终用户并控制成本。我们的增强型 GPU 处理能力与强大的企业成本管理中心相结合,为客户提供了改进的 AI 和 ML 编排、计算和调度管理,作为 ClearML MLOps 平台的一部分——该平台开箱即用,取代了对独立编排解决方案的需求,同时鼓励 ML 和数据科学团队成员进行自助服务。工程师现在拥有内置功能,比以往任何时候都更容易监控、控制和配置计算资源。

ClearML 已被认证为 NVIDIA AI Enterprise 合作伙伴,能够运行 NVIDIA AI Enterprise,这是一个用于构建加速生产 AI 的端到端平台。ClearML 平台与来自领先服务器制造商的 NVIDIA DGX™ 系统和 NVIDIA 认证系统™ 完全兼容并进行了优化。这种兼容性提高了工作流程效率和 GPU 电力优化,帮助公司最大化其 ML 投资。

广泛的灵活性

ClearML 确保当使用 ClearML 的权限设置、凭证管理和自动配置时,DevOps 和 ML 工程师无需为每个需要机器的用户进行干预。每个集群的事件历史记录会自动记录,便于审计和整体治理。

此外,ClearML 的策略管理为 DevOps 工程师提供了轻松的工具,除了作业调度和优先级设置外,还可以管理配额和 GPU 超额订阅。

大规模可扩展性

除了帮助公司管理其本地计算资源使用外,还应注意,ClearML 的 Autoscaler(自动伸缩器)功能已使公司能够更有效地管理云和混合环境设置,仅在需要时自动配置云机器。对于成本管理,团队可以为资源使用设置预算,并按类型、节点和空闲超时设置限制。即使是已配置的 GPU,如果机器在预定时间内处于空闲状态,也可以自动停止,从而节省能源和成本。对预算格外敏感的团队还有额外的选项,以确保云机器使用 Spot 实例且不受区域限制,当 Spot 实例丢失时自动重新启动,无需任何外部干预即可无缝地继续运行作业。

对于云或云混合环境设置,ClearML 的 Autoscaler(自动伸缩器)和 Spillover(溢出)功能允许企业严格管理预算和成本。当计划的作业超出现有的本地 GPU 资源时,Spillover 功能支持安全地使用云计算资源。Autoscaler 功能(可与 Spillover 结合使用或单独使用)会自动在云端配置机器来运行作业,并在机器空闲时将其停止,从而防止浪费成本。为了进一步控制成本和获得可用性选项,团队可以设置作业是运行在常规实例还是 Spot 实例上,并且不受区域限制。

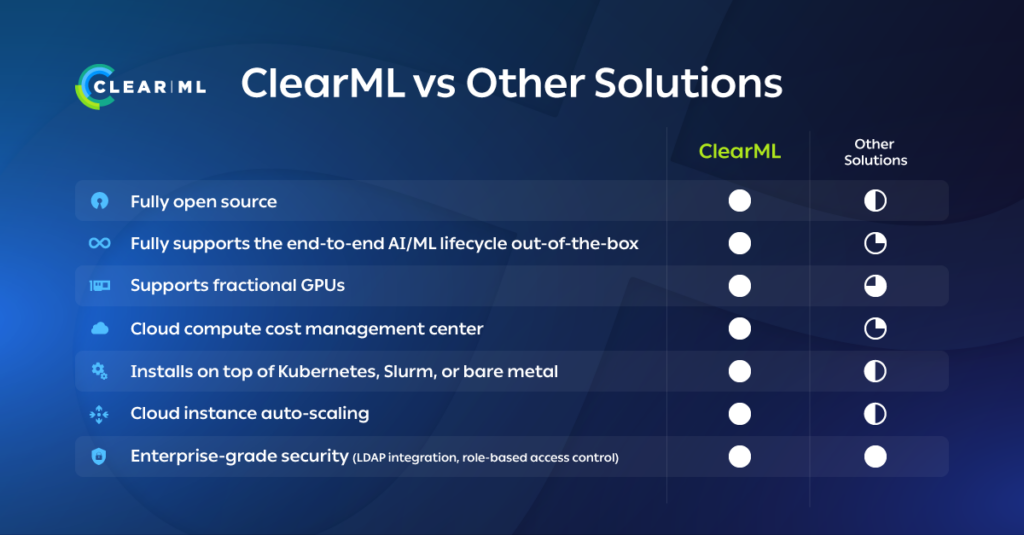

ClearML 提供无缝的端到端 MLOps 和 LLMOps,将完整的编排、调度和计算管理集成到整个 AI/ML 生命周期中。通过这种方式,ClearML 支持并服务于整个 AI、ML 和数据科学团队,这与其他仅服务于 DevOps、且没有为其他团队成员提供安全内置的 ML/DL 跟踪和监控功能的解决方案不同。

此外,ClearML 可以安装在 Slurm(一种广泛使用的免费开源 HPC 解决方案)、Kubernetes 和裸机之上,用于管理调度和计算。ClearML 也完全不依赖于硬件和云平台,最大化了公司选择和使用供应商的自由度,并通过允许本地/云混合组合来优化成本。

面向 DevOps 的 AI 基础设施

DevOps 团队还可以通过分配 GPU 分块、管理超额订阅、整合以及更精细地管理调度和优先级,确保 GPU 资源得到充分利用。使用 ClearML,团队可以通过策略管理器完全控制作业优先级以及队列或配额内的作业顺序。通过创建自动化来更有效地管理作业,DevOps 团队可以节省大量时间和精力。

通过编排和调度驱动 ClearML 的核心 AI/ML 平台,用户和管理员访问计算资源都变得更加简单。ClearML 平台以企业级安全性为考量而构建,提供基于角色的访问控制。结合项目级用户凭证,ClearML 会自动为需要机器进行数据预处理、模型训练或模型服务的用户配置预设机器。对于原生集成的推理服务器,模型部署自动伸缩是自动的,支持 CPU & GPU 专用节点。如果您还没有 AI/ML 平台,或者正在重新评估您的工具包,请查看 由 AI 基础设施联盟整理的 AI/ML 解决方案全景图。

ClearML 还为模型治理提供透明度和完整的溯源能力。每个集群的每个事件都会自动记录,便于审计。ClearML 完全开源且可扩展,可以安装在云端、虚拟机、裸机、Slurm 或 Kubernetes 上。ClearML 支持原生 Kubernetes、OpenShift 和 RancherOS。该平台也不依赖于硬件和云平台,使企业可以自由选择自己的基础设施供应商,并优化本地/云混合组合。

如果您的公司需要更好地管理其 GPU 计算资源以节省时间、优化利用率并推动您的 AI/ML 项目,请立即申请 ClearML 演示。