阅读关于企业采用生成式人工智能的隐藏成本、挑战和总拥有成本,以及高管在规模化释放人工智能潜力方面的关键考量、挑战和策略

ClearML 最近与人工智能基础设施联盟 (AIIA) 合作,就企业采用生成式人工智能进行了两份全球调查报告。我们调查了 1,000 名负责在其组织内主导生成式人工智能计划的 AI 领导者和高管。这两份调查报告都阐明了这些专业人士在规模化释放生成式人工智能潜力方面面临的采用情况、经济影响以及重大挑战。

在我们的第一份报告《企业生成式人工智能采用:高管在规模化释放人工智能潜力方面的关键考量、挑战和策略》中,我们发现虽然大多数受访者表示他们需要规模化生成式人工智能,但他们也表示缺乏预算、资源、人才、时间和技术来实现这一目标。鉴于人工智能对收入、新产品创意和功能优化具有倍增效应,显然公司需要进行关键的资源分配,才能有效地投资于人工智能以转型其组织。企业采用生成式人工智能的主要挑战包括:

- 规模化管理总体运行成本和可变成本

- 对大型语言模型(LLM)的性能拥有全面的监督和理解

- 招聘人力资本以及缺乏专业人才

- 在管理成本和总拥有成本(TCO)的同时提高效率和生产力

- 增强治理和可见性

第一份调查和研究报告的主要发现

按部门和业务单元划分的企业采用情况

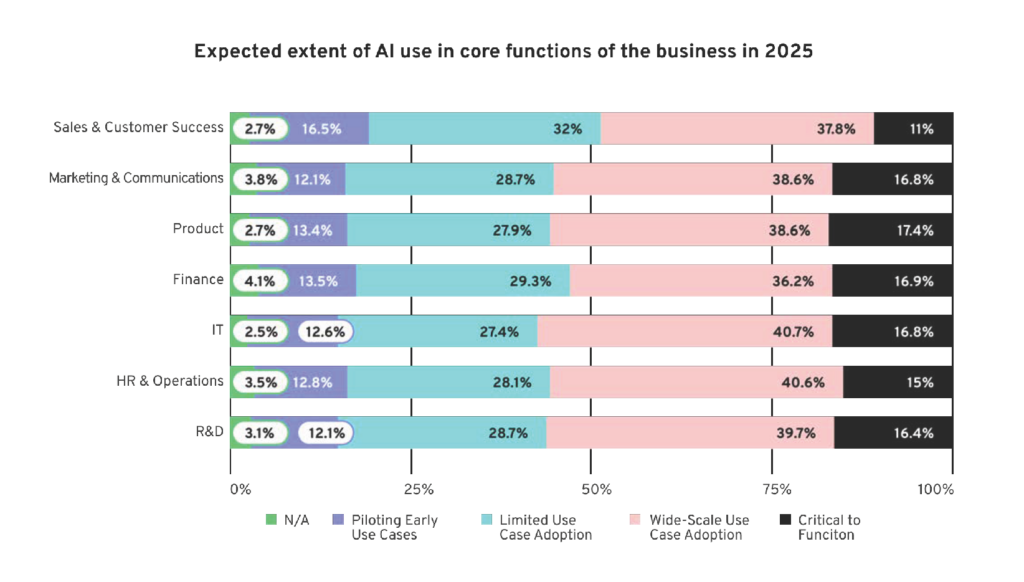

当被问及生成式人工智能在2025年其业务核心功能中的预期使用程度时,大多数受访者认为以下部门到2025年将实现有限、广泛或关键用例的采用

采用计划

- 81%的受访者认为释放人工智能和机器学习创造商业价值是一项关键的优先事项。

- 78%的企业计划在2023年期间采用xGPT / LLMs / 生成式人工智能,另有9%计划在2024年开始采用。

收入预期

- 57%的受访者所在的董事会预计未来财年人工智能/机器学习投资将带来两位数的收入增长,而37%预计将带来个位数的增长。

资源限制与影响

- 59%的高管缺乏成功采用生成式人工智能所需的预算和资源,阻碍了价值创造。

- 66%的受访者面临着由于资金不足和人员配备不足而难以量化其人工智能/机器学习项目对最终收益的影响和投资回报率(ROI)的挑战。

- 42%的人需要更多专业的机器学习人员来确保成功。

企业挑战与阻碍

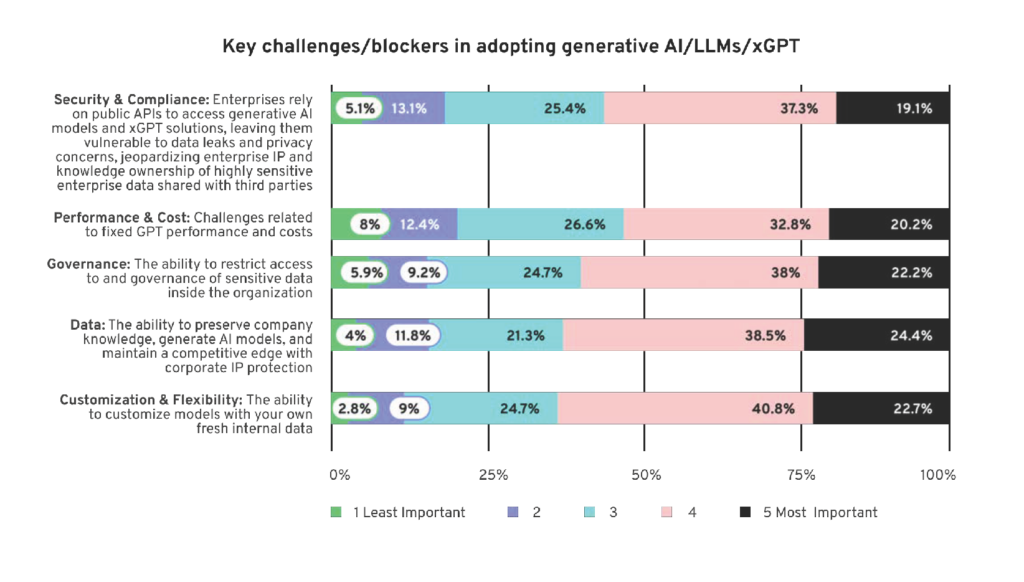

当被要求评估在其组织和业务单元中采用生成式人工智能 / 大型语言模型(LLMs) / xGPT 解决方案的关键挑战和阻碍时,受访者认为以下五个关键挑战最为重要:

平台标准化

- 88%的受访者表示,他们的组织正在寻求在各部门标准化使用单一的人工智能/机器学习平台,而不是为不同团队使用不同的点解决方案。

在我们的第二份报告《企业生成式人工智能采用的隐藏成本、挑战和总拥有成本》中,我们着重探讨了企业采用生成式人工智能的隐藏成本和未知因素。我们试图揭示人工智能领导者如何在新兴领域应对与生成式人工智能相关的隐藏运营成本,这些成本通常被描述为不熟悉且不可预测。我们还探讨了全球组织如何平衡生成式人工智能投资与预期成果,以及其总体运行成本和可变成本。

我们的研究结果表明,对于组织和人工智能领导者而言,制定有效、战略性的方法来计算、预测和控制这些根据自身组织及其独特业务用例量身定制的成本至关重要。因此,我们选择确定人工智能领导者和高管对于准确预测和预估其组织中生成式人工智能的总拥有成本(TCO)和投资回报率(ROI),同时考虑设置、训练、维护、运行成本、特定用例以及计算等可变成本等关键因素和成本驱动因素的信心程度。

第二份调查和研究报告的主要发现

1) 盲点:受访者未考虑生成式人工智能的总成本

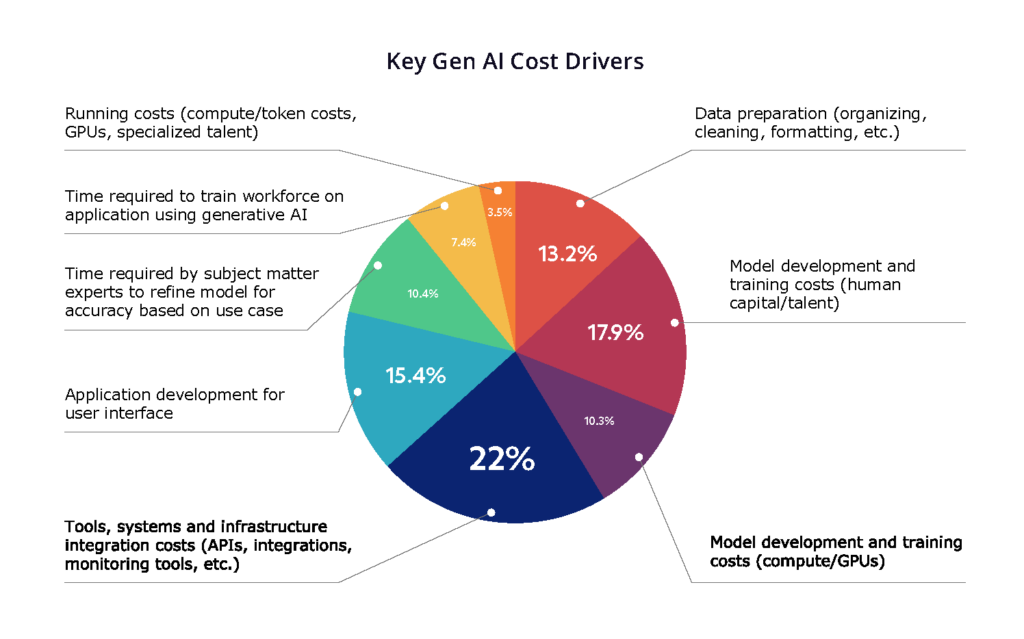

根据调查回答,我们发现大多数受访者认为他们的生成式人工智能成本主要集中在模型开发、训练和系统基础设施上。例如,与模型如何运作相关的成本——人力资本、运行模型的工具和系统,以及面向用户的应用/UI。不幸的是,现实情况大相径庭。我们认为受访者低估了数据的混乱程度以及数据准备所需的繁重工作。值得注意的是,如果公司使用 AI 即服务(例如,使用 API 连接到像 OpenAI ChatGPT、Google Bard 或 Cohere™ Generate 这样的 LLM),这甚至更具挑战性。类似地,受访者低估了主题专家(SMEs)与工程团队合作以确保模型准确且“足够好”可以部署所需的时间。最重要的是,令人震惊的是只有 8% 的受访者表示他们会尝试通过限制模型和/或限制对生成式人工智能的访问来更好地管理预算,这意味着他们没有考虑运行成本,鉴于运行成本对总拥有成本(TCO)的关键影响,我们预计这将给他们带来巨大的意外,因为运行成本是一个昂贵的成本驱动因素。

2) 不切实际的期望:大多数公司希望自行实施和运行生成式人工智能

几乎所有受访者 (91%) 都计划配置内部资源或人员来支持未来的生成式人工智能工作。这对那些似乎都在其人才库中构建生成式人工智能能力的顾问公司来说是个坏消息,但这确实让我们相信组织正在考虑长期规模化生成式人工智能。然而,这需要对他们未来的预算编制方式以及如何最有效地利用年度预算进行认真考量。他们很可能高估了他们可以用预算完成的工作量,尤其是考虑到上述发现。有趣的是,有 21% 的受访者希望利用现有团队,这意味着寻找更多方法来有效地扩大自身规模,以更少的投入做更多的事——或者只是生产更少的模型。

3) 关键优先排序:在预算内选择实施用例的关键

虽然 82% 的受访者正在为其组织考虑 4-9 个用例,最终用户数量从 501 人到 5,000 人不等,但令人担忧的是,只有 20% 的受访者分配了超过 200 万美元的年度预算。这令人担忧,因为根据 ClearML 的总拥有成本(TCO)计算器,使用内部团队为 3,000 名员工训练、微调和提供模型的第一年成本约为 100 万美元(取决于数据语料库和用例),通过共享计算资源可以实现未来的规模经济。

同时,32% 的受访者表示他们目前正在使用 ChatGPT,这些受访者可能会发现跨业务规模化相当昂贵,因为成本会随着 token 使用量线性增长。我们很难理解这种使用方式最终将如何适应预估的未来预算,这是愿景与现实之间的又一差距。

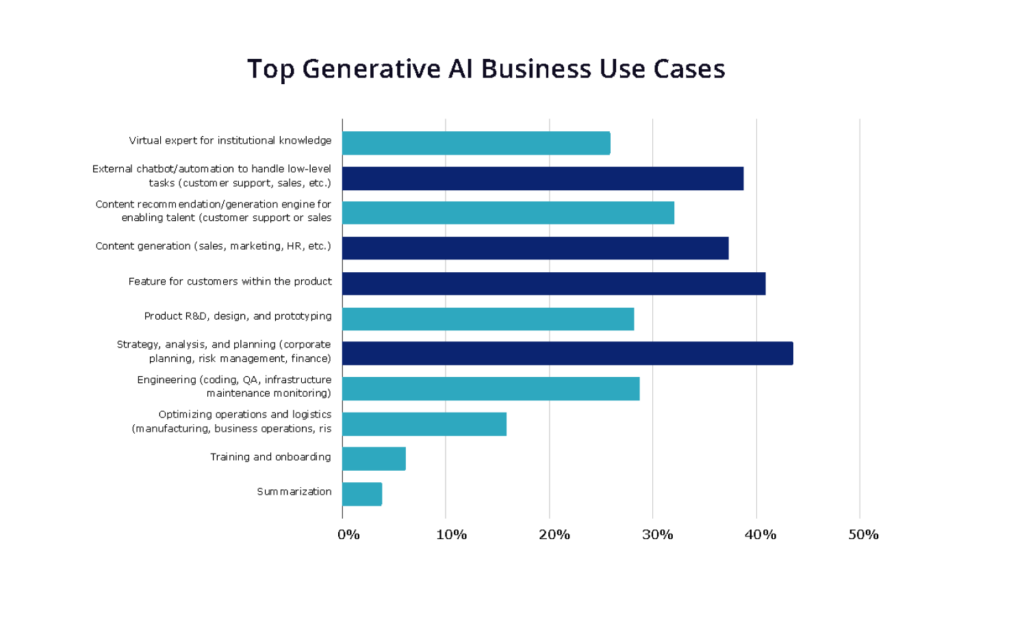

4) 一刀切行不通:组织需要各种各样的生成式人工智能工具和模型

我们发现 37% 的受访者计划将生成式人工智能用于内容生成,这可以通过 Jasper™ 和 Copy.ai 等流行的开箱即用型单用例应用程序或 Cohere™ Generate 等可用的 LLM API 实现。这种用例是成本最低的,因为组织只需按用户订阅成本较低的现成应用程序即可。最重要的是,组织无需与应用程序开发商共享专有数据,因此这也是一项低风险活动,易于外包。

话虽如此,三个最常被要求的用例需要大量访问内部文档和内部组织数据才能产生准确和有用的结果。这些用例是:

- 支持内部团队的内容推荐引擎

- 战略、企业规划和财务助手;以及

- 将生成式人工智能作为产品功能

这些用例的模型可能需要在内部部署,很可能是在本地部署,以保护公司数据和知识产权。这意味着企业需要投入资金组建内部团队,以支持多个用例的多个模型。

5) 现实差距:限制对生成式人工智能的访问不被视为控制预算的有效方法

92% 的受访者致力于随着用户增长而增加预算,并且不想通过限制访问来压缩预算。42% 的受访者表示他们会增加预算以适应更多用户,50% 将尝试通过规模经济来寻找节省。

然而,通过 AI 即服务实现规模经济几乎是不可能的,因为服务的使用价格会随使用量线性增加。不仅如此,提示工程工作通常针对每个用例进行定制,因此对于运行多个用例的企业来说,无法节省时间/精力。对于为不同业务单元和用例运行多个模型的企业来说,实现规模经济的最简单方法是通过资源池化:利用可以跨业务构建、维护和监控模型的人力资本,以及共享计算能力进行服务。

另一个突出宣传愿景与现实之间差距的问题是,愿意允许员工访问生成式人工智能(虽然这很棒)将导致成本螺旋式上升,这可能会让组织措手不及。随着使用量增加而低估成本似乎是这项全球调查结果中的一个共同主题。这可能会让组织未来陷入非常困难的境地,可能导致资源重新分配,并在年中需要追加预算以弥补使用量差距。

6) 买方自负:人工智能领导者惊人地难以预测其业务未来生成式人工智能的隐藏成本

如前所述,只有区区 9% 的受访者正在考虑运行成本;任何不考虑生成式人工智能总拥有成本的组织在账单到期时都会大吃一惊。

同时,三分之一的受访者承认 OpenAI 的 API 速度慢/无响应/不稳定,并且 LLM 模型 API 的成本很高和/或增长过快,尽管 64% 的受访者接受可能超过 200 美元/年/用户的成本。但将此与 50% 的受访者认为在部署第一年将有 11-25% 的员工使用生成式人工智能,在第二年将升级到 26-50% 的员工的情况进行比较,你就可以看到利润增长的速度以及总成本将如何累积。

两份报告的结论是什么?各种规模的组织似乎都没有做好规模化生成式人工智能的准备。尽管他们认识到运行成本很高,但他们并未将其计入成本驱动因素的预测和估计中。我们认为,组织需要更好地将其生成式人工智能战略与其业务目标和运营预算对齐,并分配必要的资源和治理,以弥合愿景与现实之间的差距。